概括

记录个人学习经历

作用域和闭包

执行上下文

针对一段 script 标签或者一个函数而言

-

JS只有全局作用域和函数作用域(在es6之前) -

使用

var声明的变量会在执行之前提升到作用域的最顶端。 -

即可以在函数声明之前调用函数。在变量声明之前调用变量(此时变量的值为

undefined)。 -

函数还包括 this,arguments

this

只有在执行的时候才能确定。包括赋值引用。注意区分构造函数内部的 this 。

可以通过 call, apply , bind 来改变 this 的指向。

闭包

返回一个函数或者传入一个函数去执行。都可以称之为闭包。

在这个闭包函数内部,可以定义变量来防止外部污染。即,私有变量。

不过需要注意内存泄露问题,因为在这边定义的变量无法自动释放。

function F1() {

var a = 100;

return function () {

console.log(a); // 自由变量,取父级作用域中的值。

};

}

var f1 = F1();

var a = 200;

f1(); // 100

创建 10 个标签,注入点击事件,分别按顺序输出 1-10

var i;

for (i = 0; i < 10; i++) {

(function (i) {

var a = document.createElement("a");

a.innerHTML = i + "<br>";

a.addEventListener("click", function (e) {

e.preventDefault();

alert(i);

});

document.body.appendChild(a);

})(i);

}

新的 es6 可以用 let 来解决这个问题。

for (let i = 0; i < 10; i++) {

var a = document.createElement("a");

a.innerHTML = i + "<br>";

a.addEventListener("click", function (e) {

e.preventDefault();

alert(i);

});

document.body.appendChild(a);

}

JS 变量复习

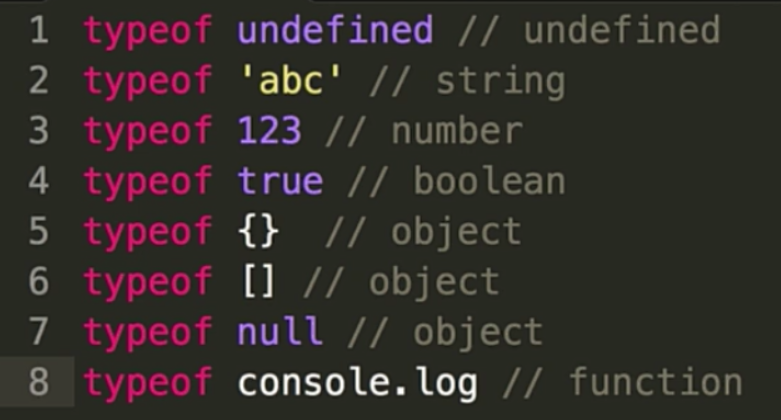

- typeof 能得到哪些类型

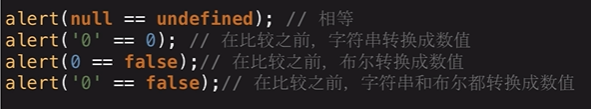

- === 和 ==

- JS 的内置函数

- 按存储方式划分,js 变量有哪些类型

- 理解 JSON

变量类型

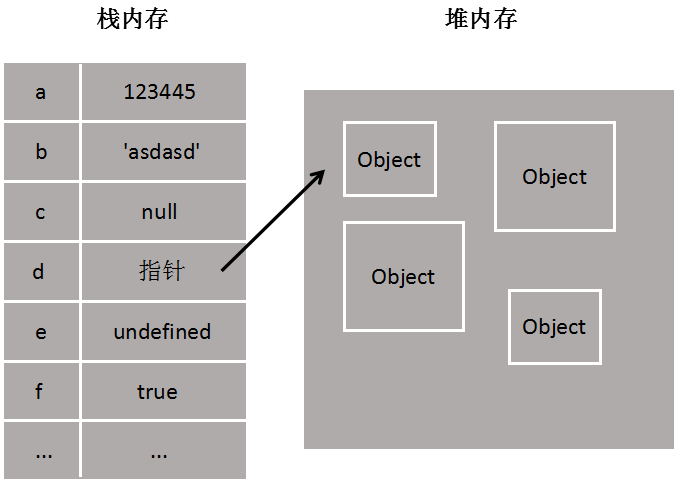

值类型和引用类型

值类型:undefined, number, boolean, string, symbol, null

引用类型:function, object

还牵扯到堆内存和栈内存的关系,稍微延伸一下。

堆内存和栈内存

栈内存主要用于存储各种基本类型的变量,包括 boolean、number、string、undefined、null,以及对象变量的指针,这时候栈内存给人的感觉就像一个线性排列的空间,每个小单元大小基本相等。

而堆内存主要负责像对象 Object 这种变量类型的存储,如下图

原始数据类型都有固定的大小保存在栈内存中,由系统自动分配存储空间,可以直接进行操作。

对于 new 出来的变量,思考一下 new 关键字所作所为,就知道,new 出来的对象都是存储在堆内存中的。

我们常说的值类型和引用类型其实说的就是栈内存变量和堆内存变量,再想想值传递和引用传递、深拷贝和浅拷贝,都是围绕堆栈内存展开的,一个是处理值,一个是处理指针。

变量定义的过程

例如var a = 10:

先将10压入栈中,然后在当前作用域中声明一个变量a,此时a = undefined,然后再将 a 关联到10。

函数定义的过程

现在堆内存中开辟一块空间,将函数的以字符串的形式存入。然后会有一个十六进制的堆内存的值。然后存入栈内存中。然后声明变量 fn,然后将 fn 关联到这个内存地址上。

垃圾回收机制

浏览器的垃圾回收机制

-

引用计数(RC)

-

标记清除

标记清除指的是当变量进入环境时,这个变量标记为“进入环境”;而当变量离开环境时,则将其标记为“离开环境”,最后,垃圾回收器完成内存清除工作,销毁并回收那些被标记为“离开环境”的值所占用的内存空间

V8 的垃圾回收机制

分代回收:新生代和老生代。

新生代的垃圾回收

在堆内存中分两个部分,一个 From(使用中的空间) ,一个 To(闲置状态),分配对象的时候先在 from 空间中进行分配,如果一个对象不再被引用了,那么将会被留在 From 中,将其他被引用的对象移动到 To 空间中,然后对调 From 和 To,最后释放 To 中的空间。

晋升

在新生代垃圾回收的过程中,当一个对象经过多次复制后依然存活,他将会被认为是生命周期较长的对象,随后会被移动到老生代中,采用新的算法进行管理

在 From 空间和 To 空间进行反转的过程中,如果 To 空间中的使用量已经超过了 25%,那么就将 From 中的对象直接晋升到老生代内存空间中

老生代的垃圾回收

老生代的内存空间是一个连续的结构。

标记清除(Mark Sweep):标记要回收的对象,直接释放相应的地址空间。执行完成之后会导致内存不连续 。

标记合并(Mark Compact):将存活的对象移动到一边,需要被回收的移动到另一边。然后对需要被回收的区域进行整体垃圾回收。

typeof

封装一个自己的类型检测方法

let class2Type = {};

let toString = class2Type.toString;

[

"Boolean",

"Number",

"String",

"Function",

"Array",

"Date",

"RegExp",

"0bject",

"Error",

"Symbol",

].forEach((name) => {

class2type["[object ${name}]"] = name.toLowerCase();

});

function toType(obj) {

// 处理null和undefined

if (obj == null) {

return obj + "";

}

return typeof obj === "object" || typeof obj === "function"

? class2Type[toString.call(obj)] || "object"

: typeof obj;

}

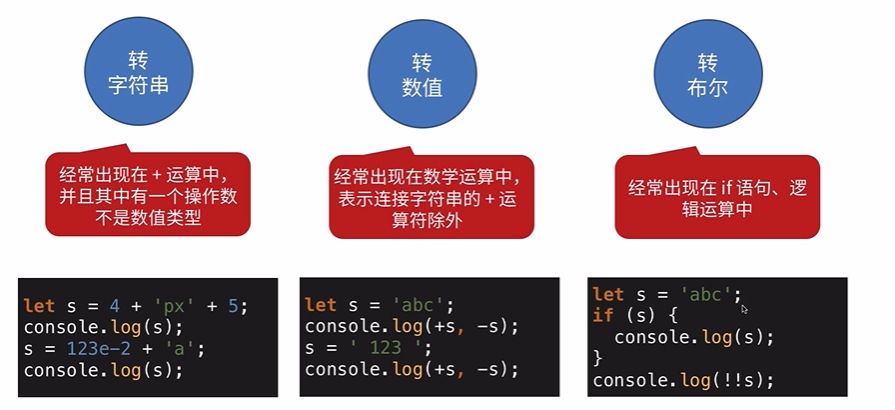

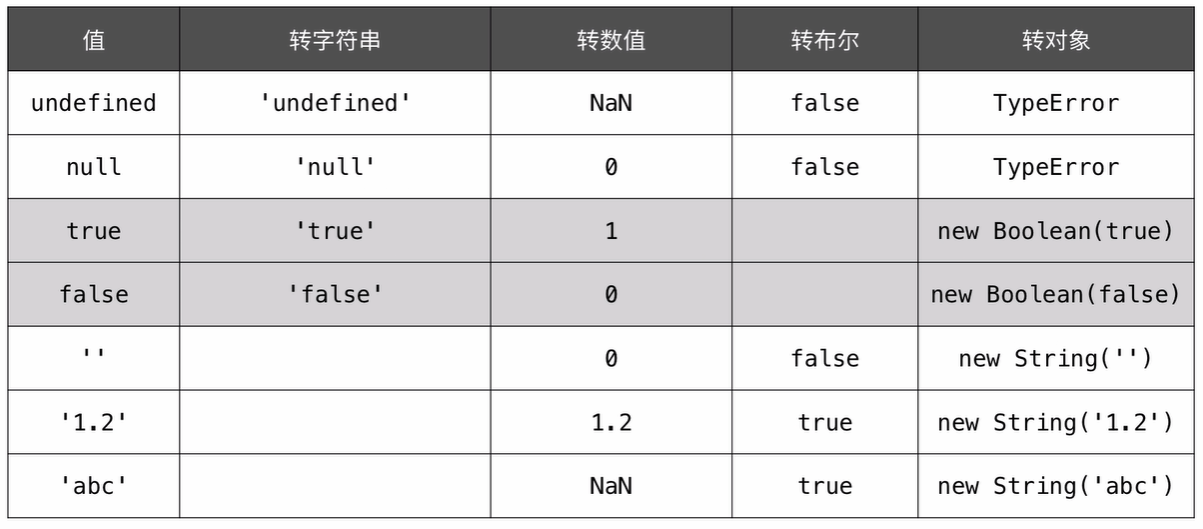

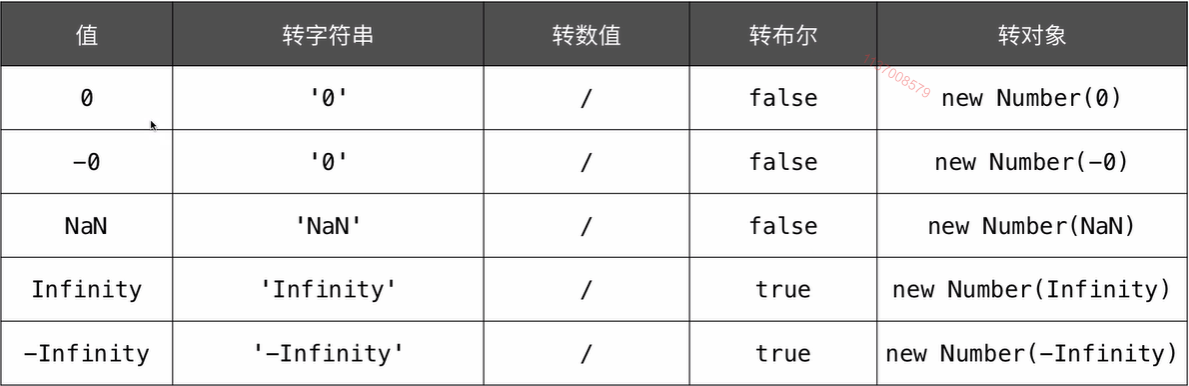

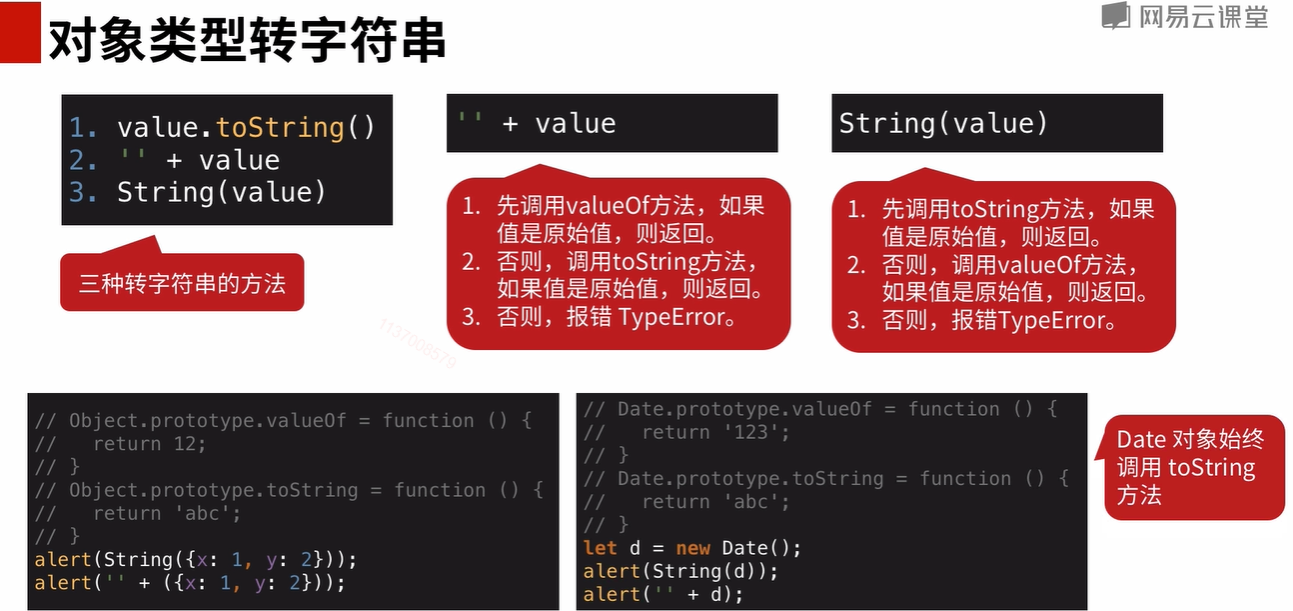

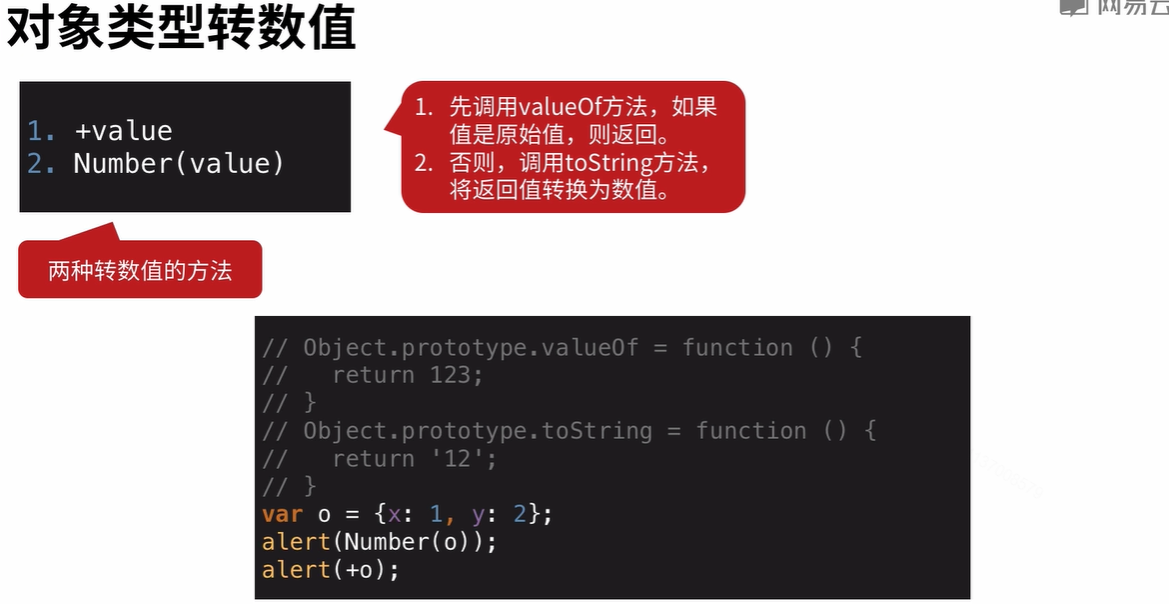

变量计算

强制类型转换的场景

- 字符串拼接

- == 运算符

- if 语句

- 逻辑运算

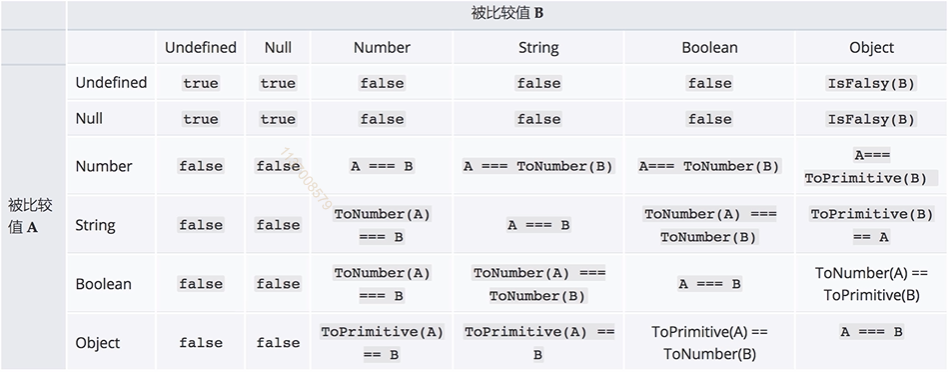

双等号的比较的时候的类型转换

// 防抖。当持续触发事件时,一定时间段内没有再触发事件,事件处理函数才会执行一次,如果设定的时间到来之前,又一次触发了事件,就重新开始延时。

let deBounce = (fn, delay) => {

let timer = null;

return function (...args) {

if (timer) {

clearTimeout(timer);

}

timer = setTimeout(() => {

fn(...args);

}, delay);

};

};

// 节流。当持续触发事件时,保证一定时间段内只调用一次事件处理函数。

let throttle = (fn, delay) => {

let flag = true;

return function (...args) {

if (!flag) return;

flag = false;

setTimeout(() => {

fn(...args);

flag = true;

}, delay);

};

};

let deBounce2 = (fn, delay) => {

let start = Date.now();

return function (...args) {

if (Date.now() - start > delay) {

fn(...args);

}

start = Date.now();

};

};

let throttle2 = (fn, delay) => {

let start = Date.now();

return function (...args) {

if (Date.now() - start > delay) {

fn(...args);

start = Date.now();

}

};

};

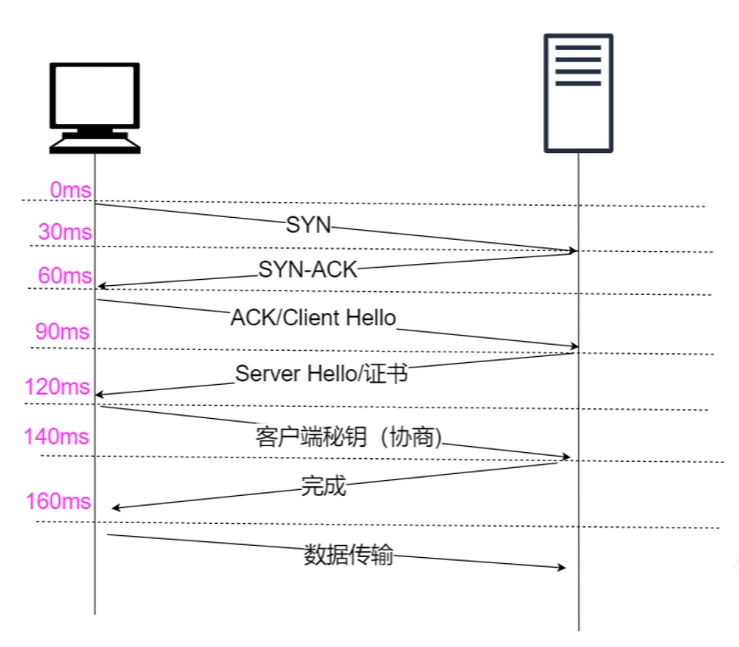

异步

JS 中的几种异步场景。

setTimeout,setInterval- 网络请求

- 事件绑定

主要是因为 JS 是单线程的。

所以为了实现异步, JS 实现了事件循环机制。

循环过程如下:

-

执行

script主线程, -

遇到

setTimeout,setInterval等宏任务,丢到宏任务队列中去,遇到Promise,nextTick等微任务,丢到微任务队列中去。 -

当前宏任务执行完毕之后,拉取所有微任务队列中的数据,全部执行完毕。

-

再取宏任务队列中的第一个任务执行。回到 2。

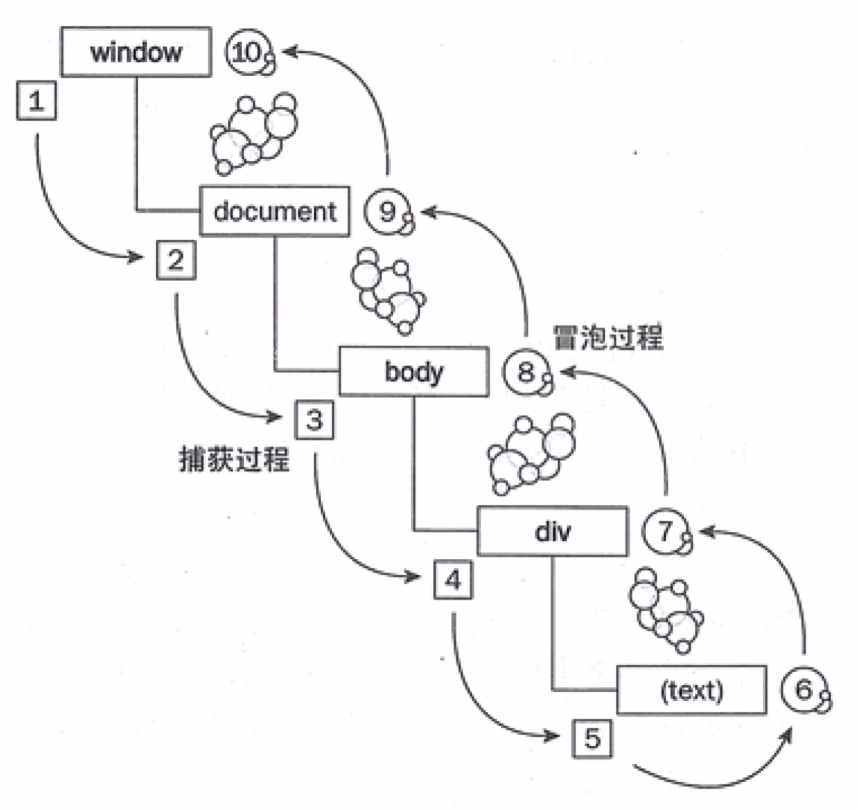

事件绑定

一个简单的通用的事件绑定函数:

function bindEvent(elem, type, selector, fn) {

if (fn == null) {

fn = selector;

selector = null;

}

elem.addEventListener(type, function (e) {

var target;

if (selector) {

target = e.target;

if (target.matches(selector)) {

fn.call(target, e);

}

} else {

fn(e);

}

});

}

网络请求

一个简单的基于原生 XMLHTTPRequest 实现的网络请求

var xhr = new XMLHttpRequest();

xhr.open("GET", "/api", false);

xhr.onreadystatechange = function () {

if (xhr.readyState == 4) {

if (xhr.status === 200) {

alert(xhr.responseText);

}

}

};

xhr.send(null);

readyState 的几种状态:

- 0 - 未初始化,还没有调用 send()方法

- 1 - 载入,已调用

send()方法,正在发送请求 - 2 - 载入完成,

send()方法执行完成,已经接收到全部响应内容 - 3 - 交互,正在解析响应内容

- 4 - 完成,响应内容解析完成,可以在客户端调用了

Promise

// 步骤一:了解promise规范

// 步骤二:实现

// 步骤三:测试

const statusMap = {

PENDING: "pending",

FULFILLED: "fulfilled",

REJECTED: "rejected",

};

// 将promise设置为fulfilled状态

function fulfilledPromise(promise, value) {

// 只能从pending状态转换为其他状态

if (promise.status !== statusMap.PENDING) {

return;

}

promise.status = statusMap.FULFILLED;

promise.value = value;

runCbs(promise.fulfilledCbs, value);

}

// 将promise设置为rejected状态

function rejectedPromise(promise, reason) {

// 只能从pending状态转换为其他状态

if (promise.status !== statusMap.PENDING) {

return;

}

promise.status = statusMap.REJECTED;

promise.reason = reason;

runCbs(promise.rejectedCbs, reason);

}

function runCbs(cbs, value) {

cbs.forEach((cb) => cb(value));

}

function isFunction(fn) {

return (

Object.prototype.toString.call(fn).toLocaleLowerCase() ===

"[object function]"

);

}

function isObject(obj) {

return (

Object.prototype.toString.call(obj).toLocaleLowerCase() ===

"[object object]"

);

}

function isPromise(p) {

return p instanceof Promise;

}

// promise的解析

function resolvePromise(promise, x) {

// x 与promise相同

if (promise === x) {

rejectedPromise(promise, new TypeError("cant be the same"));

return;

}

// x 是promise

if (isPromise(x)) {

if (x.status === statusMap.FULFILLED) {

fulfilledPromise(promise, x.value);

return;

}

if (x.status === statusMap.REJECTED) {

rejectedPromise(promise, x.reason);

return;

}

if (x.status === statusMap.PENDING) {

x.then(

() => {

fulfilledPromise(promise, x.value);

},

() => {

rejectedPromise(promise, x.reason);

}

);

return;

}

return;

}

if (isObject(x) || isFunction(x)) {

let then;

let called = false;

try {

then = x.then;

} catch (error) {

rejectedPromise(promise, error);

return;

}

if (isFunction(then)) {

try {

then.call(

x,

(y) => {

if (called) {

return;

}

called = true;

resolvePromise(promise, y);

},

(r) => {

if (called) {

return;

}

called = true;

rejectedPromise(promise, r);

}

);

} catch (error) {

if (called) {

return;

}

called = true;

rejectedPromise(promise, error);

}

return;

} else {

fulfilledPromise(promise, x);

return;

} // x不是对象或者函数

} else {

fulfilledPromise(promise, x);

return;

}

}

class Promise {

constructor(fn) {

this.status = statusMap.PENDING;

this.value = undefined;

this.reason = undefined;

this.fulfilledCbs = []; // then fulfilled callback

this.rejectedCbs = []; // then rejected callback

fn(

(value) => {

// 防止直接传进来一个thenalbe

// fulfilledPromise(this, value);

resolvePromise(this, value);

},

(reason) => {

rejectedPromise(this, reason);

}

);

}

// 两个参数

then(onFulfilled, onRejected) {

const promise1 = this;

const promise2 = new Promise(() => {});

if (promise1.status === statusMap.FULFILLED) {

if (!isFunction(onFulfilled)) {

return promise1;

}

setTimeout(() => {

try {

const x = onFulfilled(promise1.value);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

}

if (promise1.status === statusMap.REJECTED) {

if (!isFunction(onRejected)) {

return promise1;

}

setTimeout(() => {

try {

const x = onRejected(promise1.reason);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

}

if (promise1.status === statusMap.PENDING) {

onFulfilled = isFunction(onFulfilled)

? onFulfilled

: (value) => {

return value;

};

onRejected = isFunction(onRejected)

? onRejected

: (err) => {

throw err;

};

promise1.fulfilledCbs.push(() => {

setTimeout(() => {

try {

const x = onFulfilled(promise1.value);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

});

promise1.rejectedCbs.push(() => {

setTimeout(() => {

try {

const x = onRejected(promise1.reason);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

});

}

return promise2;

}

}

// 测试用到的钩子

Promise.deferred = function () {

const deferred = {};

deferred.promise = new Promise((resolve, reject) => {

deferred.resolve = resolve;

deferred.reject = reject;

});

return deferred;

};

module.exports = Promise;

Generator

一个可迭代的对象的例子:

function createIterator(items) {

var i = 0;

return {

next: function () {

var done = i >= items.length;

var value = !done ? items[i++] : undefined;

return {

done: done,

value: value,

};

},

};

}

var iterator = createIterator([1, 2, 3]);

iterator.next();

iterator.next();

iterator.next();

iterator.next();

使用 yield 的情况, yield 会替换前一个的返回值。

// yield 例子

function* createIterator() {

let first = yield 1;

let second = yield first + 2;

yield second + 3;

}

let iterator = createIterator();

iterator.next();

iterator.next(4);

iterator.next(5);

iterator.next();

Thunk 函数自动执行 generator:

// 代码

function run(fn) {

var gen = fn(); //获得生成器对象

// 递归调用自身的方法(类似尾递归的思路,执行完之后调用自身)

function next(err, data) {

// 获取生成器next执行之后的返回值。

var result = gen.next(data);

// 如果done了,就返回

if (result.done) return;

// 如果没有done,就调用自身,给fs.readFile的回调,让它在执行完之后

// 执行next,next的传参是callback的传参

result.value(next);

}

// 先执行一次

next();

}

const Thunk = function (fn) {

return function (...args) {

return function (callback) {

return fn.call(this, ...args, callback);

};

};

};

// 使用

const fs = require("fs");

const readFileThunk = Thunk(fs.readFile);

const g = function* () {

const s1 = yield readFileThunk("xxx.xx");

console.log(s1);

const s2 = yield readFileThunk("xxx.xx");

console.log(s2);

};

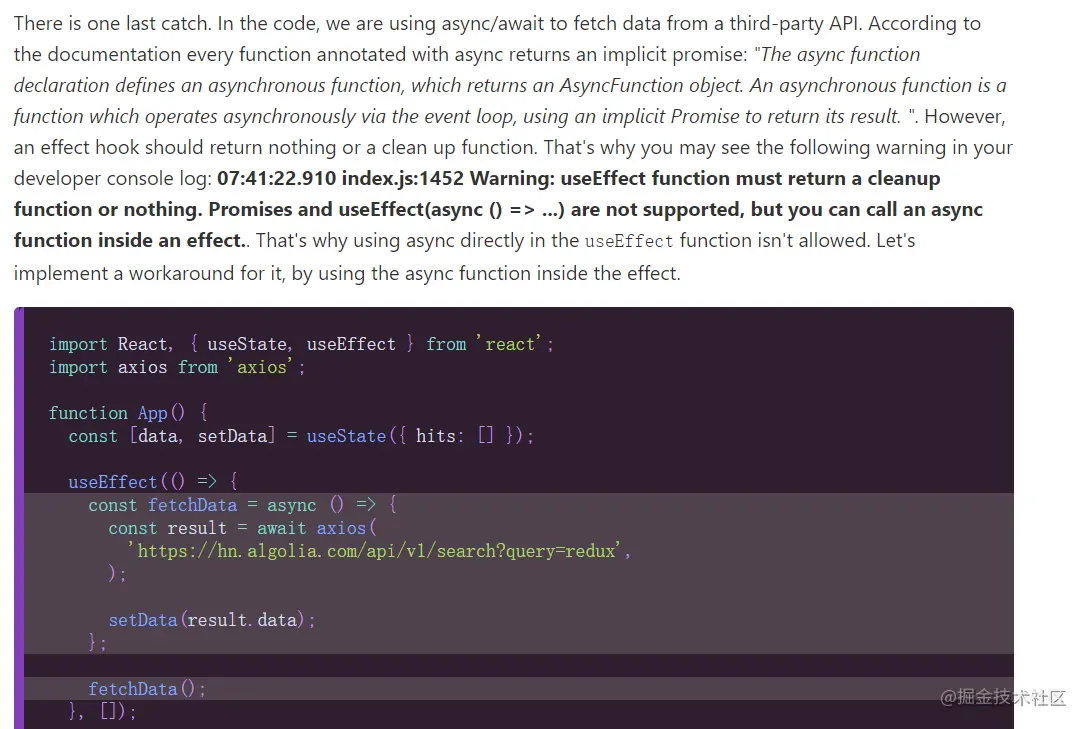

async/await

async/await 其实就是 generator 的语法糖, await 会被转译成 yield ,然后通过 generator 自执行来完成异步。

其实就是使用了 Promise.then 来完成上面的 callback 完成的东西,保证了返回值是 Promise。

async function example(params) {

// xxx

}

// =>

function example(params) {

return spawn(function* () {

// xxx

});

}

function spawn(genF) {

return new Promise(function (resolve, reject) {

const gen = genF(); // 生成器对象

function step(nextF) {

let next;

try {

next = nextF(); // 执行gen.next

} catch (e) {

return reject(e);

}

if (next.done) {

return resolve(next.value);

}

Promise.resolve(next.value).then(

function (v) {

step(function () {

return gen.next(v);

});

},

function (e) {

step(function () {

return gen.throw(e);

});

}

);

}

step(function () {

return gen.next(undefined);

});

});

}

实现 new

function myNew(Ctr, ...args) {

if (typeof Ctr !== "function") {

throw new TypeError("Constructor must be a function");

}

// 创建原始对象

// let obj = {};

// 设置新对象的prototype

// Object.setPrototypeOf(obj, Ctr.prototype);

// 创建原始对象,Object.create可以以参数为prototype创建一个新对象

let obj = Object.create(Ctr.prototype);

const result = Ctr.apply(obj, args);

// 判断一下,防止构造函数指定了返回值

return result !== null &&

(typeof result === "object" || typeof result === "function")

? result

: obj;

}

实现 call,apply

call 是参数一个个传进去,apply 是参数以数组形式传进去

Function.prototype.myCall = function (context) {

// 获取剩余参数

let args = [...arguments].slice(1),

// 定义Symbol类型的key

key = Symbol("KEY"),

result = null;

// 如果不是object或者function类型,则装箱使其可以被增加属性

!/^(object|function)$/i.test(typeof context)

? (context = Object(context))

: null;

context[key] = this;

result = context[key](...args);

delete context[key];

return result;

};

bind,利用闭包暂存 this

Function.prototype.myBind = function (context, ...params) {

let self = this;

return function proxy(...args) {

self.apply(context, params.concact(args));

};

};

注意点:

Object.keys,for in循环遍历的时候不能包含Symbol属性(ES6 解构运算符可以)- 各种类型的处理

- 循环引用

let keys = [...Object.keys(obj), ...Object.getOwnPropertySymbols(obj)];

// 浅克隆

function shallowClone(obj) {

let type = _.toType(obj);

Ctor = obj.constructor;

// 对于SymFol/BigInt,直接用Object包裹一下

if (/^(symbol|bigint)$/i.test(type)) return Object(obj);

//对于正则/日期的处理

if (/^(regexp|date)$/i.test(type)) return new Ctor(obj);

//对于错误对象的处理

if (/^error$/i.test(type)) return new Ctor(obj.message);

// 对于函数

if (/^function$/i.test(type)) {

return function () {

return obj.call(this, ...arguments);

};

}

//数组或者对象

if (/^(object|array)$/i.test(type)) {

let keys = [...Object.keys(obj), ...Object.getOwnPropertySymbols(obj)];

let newObj = new Ctor();

_.each(keys, (key) => {

newObj[key] = obj[key];

});

return newObj;

/* ES6 解构运算符可以处理Symbol属性

return type === "array" ? [...obj] : { ...obj };

*/

}

return obj;

}

// 深克隆

function deepClone(obj, cache = new Set()) {

let type = _.toType(obj);

Ctor = obj.constructor;

if (!/^(object|array)$/i.test(type)) {

return shallowClone(obj);

}

// 防止循环引用

if (cache.has(obj)) return obj;

cache.add(obj);

let keys = [...Object.keys(obj), ...Object.getOwnPropertySymbols(obj)];

let newObj = new Ctor();

_.each(keys, (key) => {

// 传入初始cache

newObj[key] = deepClone(obj[key], cache);

});

return newObj;

}

函数相关

compose 函数和 pipe 函数

函数组合,将多个函数组合在一起。

compose 函数

- 将需要嵌套执行的函数平铺

- 嵌套执行指的是,一个函数的返回值作为另一个函数的参数

compose 函数主要是实现了函数式编程中的 pointfree ,使我们专注于转换而不是数据本身。

也就是说,我们可以把数据处理的过程,定义成一种与参数无关合成运算。不需要关注参数本身,只需要将运算合成即可。

pointfree 就是不使用所要处理的值,只合成运算过程。即无参数分隔。

let compose = function () {

// 将arguments转为数组

let args = [].slice.call(arguments);

return function (params) {

// 自右向左,依次执行

return args.reduceRight(function (res, cb) {

return cb(res);

}, params);

};

};

es6 版:

const compost =

(...args) =>

(params) =>

args.reduceRight((res, cb) => cb(res), params);

Redux 就是依赖 compose 来实现中间件的功能的。

Webpack 的 loader 也是。

pipe 函数

pipe 就是 compose 的复制版,只不过执行方向变了,改为从左向右

export default function Pipe(...funcs) {

return (params) => funcs.reduce((res, cb) => cb(res), params);

}

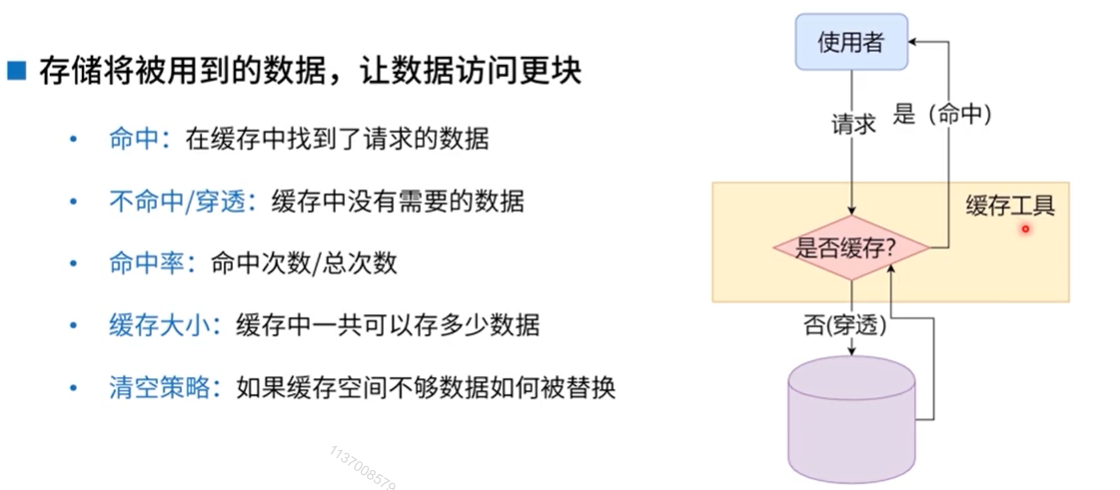

常用函数

memozition

将上次的计算结果缓存起来,当下次调用时,如果遇到了相同的参数,就直接返回缓存中的数据

原理:

将参数和对应结果存储到一个对象中,调用时,先判断参数对应的数据是否存在,如果存在则直接返回,如果不存在才计算并存到缓存中。

闭包的灵魂体现!

lodash 中的 memoize 实现:

// func是需要缓存的函数,resolver是计算key的函数

function memoize(func, resolver) {

// 类型校验

if (

typeof func !== "function" ||

(resolver != null && typeof resolver !== "function")

) {

throw new TypeError("Expected a function");

}

const memoized = function (...args) {

// 先计算一下key,如果没有计算函数,则取第一个参数

const key = resolver ? resolver.apply(this, args) : args[0];

// 取缓存

const cache = memoized.cache;

// 如果缓存中有值,则直接返回

if (cache.has(key)) {

return cache.get(key);

}

// 缓存中没有值,先计算,再放入缓存中,再更新缓存

const result = func.apply(this, args);

memoized.cache = cache.set(key, result) || cache;

return result;

};

// 缓存初始化为Map

memoized.cache = new (memoize.Cache || Map)();

// 返回缓存函数

return memoized;

}

memoize.Cache = Map;

export default memoize;

使用场景:

需要大量重复计算或依赖之前的结果的情况

比如斐波那契数列

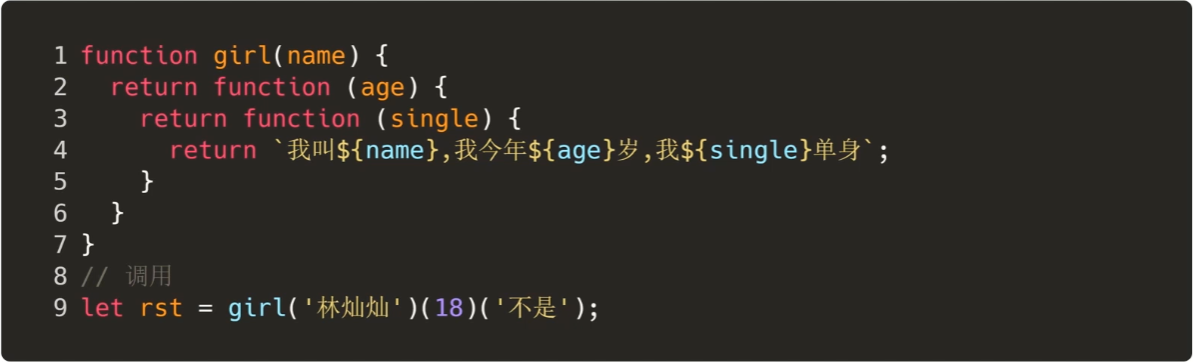

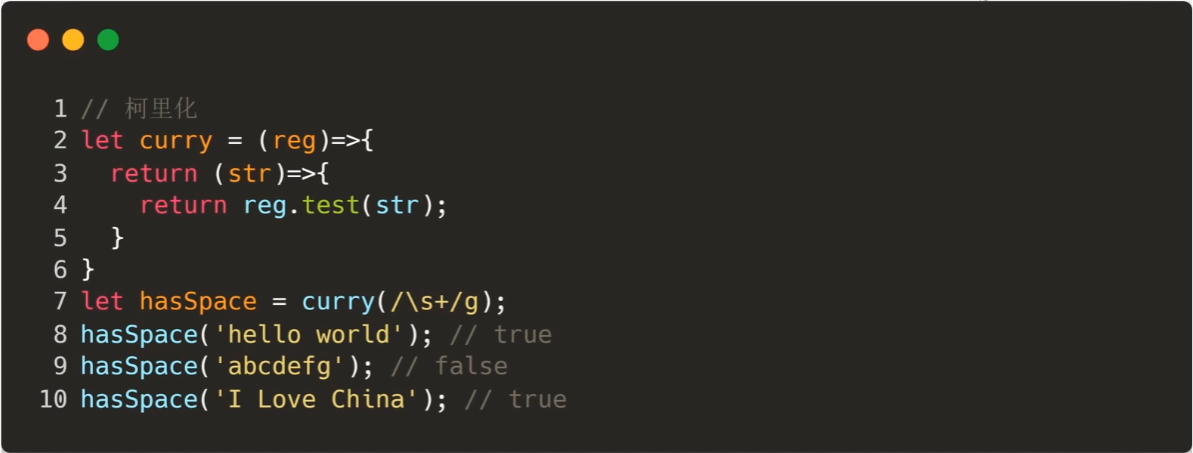

curry

将使用多个参数的一个函数,转化成一系列使用一个参数的函数的技术。

比如,使用正则校验一个字符串:

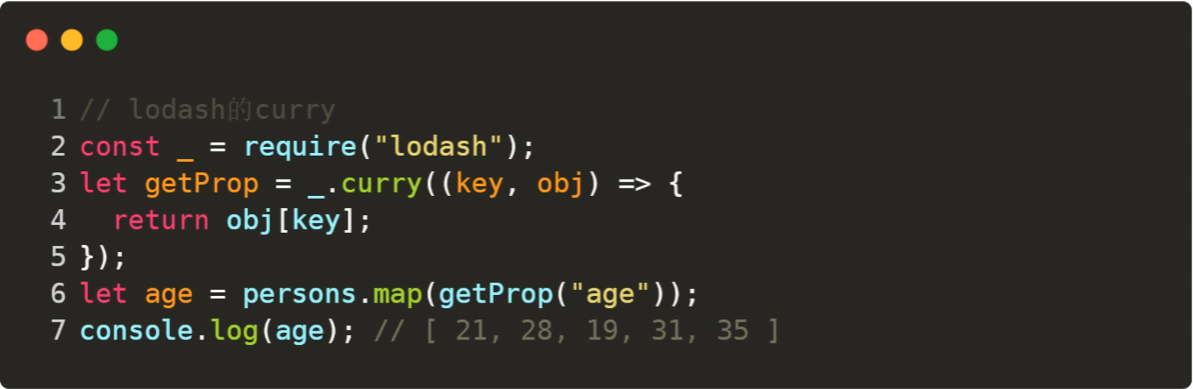

或者从对象数组中取某一个字符的值

在调用 getProp("age") 之后,这个的返回值,就变成了接受一个对象并返回对象的 age 属性的函数,放在 map 中就很舒服了。

偏函数

如果说,柯里化是将一个多参数函数转换成多个单参数函数,也就是将一个 n 元函数转换成 n 个一元函数。

那么偏函数就是固定一个函数的一个或者多个参数,也就是将一个 n 元函数转换成一个 n-x 元函数。

也就是:

柯里化: f(a,b,c) => f(a)(b)(c)

偏函数: f(a,b,c) => f(a,b)(c)

可以简单实用 bind 来实现

let add = (x, y) => x + y;

let rst = add.bind(null, 1);

rst(2); // 3

时间窗口

在一定时间内,如果请求同一个 url,则只请求一次。

const fetch = require("node-fetch");

function hash(...args) {

return args.join(",");

}

function window_request(f, time = 50) {

let w = {};

// 是否有时间窗口

let flag = false;

return (...args) => {

return new Promise((resolve) => {

// 如果w中没有这次请求(通过hash存入), 如果有,则在最后 L54 将resolve存入到对应的resolvers里

if (!w[hash(args)]) {

w[hash(args)] = {

func: f,

args,

// 将不同的request的resolve也添加进来,方便最后统一做处理。

resolvers: [],

};

}

// 如果没有时间窗口

if (!flag) {

// 接下来是创建一个时间窗口

console.log("create a window");

flag = true;

setTimeout(() => {

// 对w中每一个请求进行处理。

Object.keys(w).forEach((key) => {

// 获取参数进行执行

const { func, args, resolvers } = w[key];

console.log("run once ---- ", resolvers.length);

func(...args)

.then((res) => {

return res.text();

})

.then((t) => {

// 将获取到的结果批量放到resolve中处理

resolvers.forEach((r) => {

console.log("result anywhere");

r(t);

});

// 重置访问窗口

flag = false;

w = {};

});

});

}, time);

}

w[hash(args)].resolvers.push(resolve);

});

};

}

const request = window_request(fetch, 20);

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

console.log("break");

setTimeout(() => {

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

request("https://www.baidu.com");

}, 10000);

指数补偿

在网络环境不稳定的情况下,以指数级别的时间间隔发送请求,直到任意某一次请求得到了返回

function request(url) {

// 判断是否已经完成请求

let resolved = false;

// 次数

let t = 1;

return new Promise((resolve, reject) => {

function doFetch() {

// 如果已经完成请求,或者次数已达上限,则直接返回

if (resolved || t > 16) {

return;

}

// 否则发送请求

fetch(url).then((resp) => {

// 如果标记还处在未完成的状态

if (!resolved) {

// 将结果返回

resolve(resp);

// 将标记置为已完成

resolved = true;

}

});

// 指数级的时间间隔发送请求

setTimeout(() => {

// 调用自己

doFetch();

t *= 2;

}, t * 100);

}

// 首次调用

doFetch();

});

}

Promise.all 并发限制

每个时刻并发执行的 promise 的数量是固定的,最终执行结果还是保持和原来的一致

const delay = function delay(interval) {

return new Promise((resolve, reject) => {

setTimeout(() => {

resolve(interval);

}, interval);

});

};

let tasks = [];

for (let index = 0; index < 6; index++) {

tasks.push(() => {

return delay(1000 + index);

});

}

Promise.all(tasks.map((task) => task())).then((results) => {

console.log(results);

});

这样会并发执行 6 个,大约 1s 左右完成。

第一种解决方案(保证了顺序)

function createRequest(tasks, pool) {

// 自定义并发数量

pool = pool || 5;

let results = [],

together = new Array(pool).fill(null),

// 存储执行位置

index = 0;

// 生成Promise.all需要并发执行的任务

together = together.map(() => {

return new Promise((resolve, reject) => {

// 定义

const run = function run() {

if (index >= tasks.length) {

resolve();

return;

}

let taskIndex = index++,

task = tasks[taskIndex];

task()

.then((result) => {

// 执行完成之后,存入结果

results[taskIndex] = result;

})

.then(() => {

// 再取出一个任务继续执行

run();

})

.catch((reason) => {

reject(reason);

});

};

run();

});

});

return Promise.all(together).then(() => results);

}

createRequest(tasks, 2)

.then((results) => {

console.log("success" + results);

})

.catch((err) => {

console.log("error" + reason);

});

第二种解决方案(不保证顺序)

createRequest(tasks, 2)

.then((results) => {

console.log("success" + results);

})

.catch((err) => {

console.log("error" + reason);

});

function createRequest2(task, pool, callback) {

// 参数校验处理,可以不传pool

if (typeof pool === "function") {

callback = pool;

pool = 5;

}

if (typeof pool != "number") pool = 5;

if (typeof callback != "function") callback = () => {};

class TaskQueue {

running = 0;

queue = [];

results = [];

pushTask(task) {

let self = this;

// 不论怎么样,都先存进去

self.queue.push(task);

// 存了之后就直接开始执行

self.next();

}

next() {

let self = this;

// 并发数量小于限制并且还有任务

while (self.running < pool && self.queue.length) {

self.running++;

// 队头取出一个任务执行

let task = self.queue.shift();

task()

.then((result) => {

self.results.push(result);

})

.finally(() => {

// 执行完成之后需要重置标识,并执行下一个任务

self.running--;

self.next();

});

}

// 全部执行完之后,执行callback

if (self.running === 0) {

callback(self.results);

}

}

}

let tq = new TaskQueue();

tasks.forEach((task) => tq.pushTask(task));

}

手撕 Promise

Promise/A+规范

术语

promise一个有 then 方法的对象或函数,行为符合本规范thenable一个定义了 then 方法的对象或函数value任何JavaScript的合法值exceptionthrow语句抛出的值reason一个标识promise被拒绝的原因的值

promise 的状态

pending只能由pending状态转换为其他两个状态fulfilled带value,不能再改变状态了。rejected带reason,不能再改变状态了。

then 方法

then 方法有两个可选参数

onFulfilled, 在promise完成后被调用,onRejected, 在promise被拒绝执行后调用- 只被调用一次

then 方法可以被调用多次 then 方法必须返回一个 promise,实现链式调用

promise 的解析过程

// promise的解析过程

function resolvePromise(promise, x) {

// x 不允许与 promise 相同

if (promise === x) {

rejectedPromise(promise, new TypeError("cant be the same"));

return;

}

// x 是 promise的情况下,根据x的状态决定promise的状态

if (isPromise(x)) {

if (x.status === statusMap.FULFILLED) {

fulfilledPromise(promise, x.value);

return;

}

if (x.status === statusMap.REJECTED) {

rejectedPromise(promise, x.reason);

return;

}

// 如果x还是pending状态,则需要等待x执行完毕,再决定promise的装忒

if (x.status === statusMap.PENDING) {

x.then(

() => {

fulfilledPromise(promise, x.value);

},

() => {

rejectedPromise(promise, x.reason);

}

);

return;

}

return;

}

// 如果x不是promise,是一个函数或者对象

if (isObject(x) || isFunction(x)) {

let then;

let called = false;

try {

then = x.then;

} catch (error) {

// 如果x上没有then方法(即不符合Promise/A+规范),直接reject

rejectedPromise(promise, error);

return;

}

// 如果有then方法,需要保证then方法只能被执行一次。(通过called)

if (isFunction(then)) {

try {

// 执行then方法

then.call(

x,

(y) => {

if (called) {

return;

}

// 设置标签位为执行过

called = true;

// 设置promise的状态

resolvePromise(promise, y);

},

(r) => {

if (called) {

return;

}

called = true;

rejectedPromise(promise, r);

}

);

} catch (error) {

// 执行异常直接抛出错误

if (called) {

return;

}

called = true;

rejectedPromise(promise, error);

}

return;

} else {

// 有then属性,但是then不是可执行函数,那么认为x就是当前的返回值

fulfilledPromise(promise, x);

return;

}

} else {

// x不是对象或者函数,是某个具体值,直接fulfilled

fulfilledPromise(promise, x);

return;

}

}

具体实现

// 步骤一:了解promise规范

// 步骤二:实现

// 步骤三:测试

const statusMap = {

PENDING: "pending",

FULFILLED: "fulfilled",

REJECTED: "rejected",

};

// 将promise设置为fulfilled状态

function fulfilledPromise(promise, value) {

// 只能从pending状态转换为其他状态

if (promise.status !== statusMap.PENDING) {

return;

}

promise.status = statusMap.FULFILLED;

promise.value = value;

runCbs(promise.fulfilledCbs, value);

}

// 将promise设置为rejected状态

function rejectedPromise(promise, reason) {

// 只能从pending状态转换为其他状态

if (promise.status !== statusMap.PENDING) {

return;

}

promise.status = statusMap.REJECTED;

promise.reason = reason;

runCbs(promise.rejectedCbs, reason);

}

function runCbs(cbs, value) {

cbs.forEach((cb) => cb(value));

}

function isFunction(fn) {

return (

Object.prototype.toString.call(fn).toLocaleLowerCase() ===

"[object function]"

);

}

function isObject(obj) {

return (

Object.prototype.toString.call(obj).toLocaleLowerCase() ===

"[object object]"

);

}

function isPromise(p) {

return p instanceof Promise;

}

class Promise {

constructor(fn) {

this.status = statusMap.PENDING;

this.value = undefined;

this.reason = undefined;

this.fulfilledCbs = []; // then fulfilled callback

this.rejectedCbs = []; // then rejected callback

fn(

(value) => {

// 防止直接传进来一个thenalbe

// fulfilledPromise(this, value);

resolvePromise(this, value);

},

(reason) => {

rejectedPromise(this, reason);

}

);

}

// 两个参数

then(onFulfilled, onRejected) {

const promise1 = this;

const promise2 = new Promise(() => {});

if (promise1.status === statusMap.FULFILLED) {

if (!isFunction(onFulfilled)) {

return promise1;

}

setTimeout(() => {

try {

const x = onFulfilled(promise1.value);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

}

if (promise1.status === statusMap.REJECTED) {

if (!isFunction(onRejected)) {

return promise1;

}

setTimeout(() => {

try {

const x = onRejected(promise1.reason);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

}

if (promise1.status === statusMap.PENDING) {

onFulfilled = isFunction(onFulfilled)

? onFulfilled

: (value) => {

return value;

};

onRejected = isFunction(onRejected)

? onRejected

: (err) => {

throw err;

};

promise1.fulfilledCbs.push(() => {

setTimeout(() => {

try {

const x = onFulfilled(promise1.value);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

});

promise1.rejectedCbs.push(() => {

setTimeout(() => {

try {

const x = onRejected(promise1.reason);

resolvePromise(promise2, x);

} catch (error) {

rejectedPromise(promise2, error);

}

}, 0);

});

}

return promise2;

}

}

// 测试用到的钩子

Promise.deferred = function () {

const deferred = {};

deferred.promise = new Promise((resolve, reject) => {

deferred.resolve = resolve;

deferred.reject = reject;

});

return deferred;

};

module.exports = Promise;

IntersectionObserver

const observer = new IntersectionObserver(callback, {

root: null, // 根元素(默认视窗)

rootMargin: "0px", // 根元素边界扩展(类似 CSS margin)

threshold: 0.5, // 触发阈值(0-1 或数组 [0, 0.25, 1])

});

图片懒加载

const vLazy = (observer: IntersectionObserver) => {

return {

beforeMount: (el: HTMLImageElement, binding : DirectiveBinding) => {

el.classList.add("op-lazyload");

const { value } = binding;

el.dataset.origin = value;

observer.observe(el);

},

};

};

const lazyPlugin = {

install(app : App) {

const observer = new IntersectionObserver((entries) => {

entries.forEach((item) => {

if (item.isIntersecting) {

const el = item.target as HTMLImageElement;

el.src = el.dataset.origin as string;

el.classList.remove("op-lazyload");

observer.unobserve(el);

}

});

});

},

};

组件懒加载

import {

h,

defineAsyncComponent,

defineComponent,

ref,

onMounted,

AsyncComponentLoader,

Component,

} from 'vue';

type ComponentResolver = (component: Component) => void

export const lazyLoadComponentIfVisible = ({

// 目标组件加载函数

componentLoader,

// 目标组件加载时使用的占位组件

loadingComponent,

errorComponent,

delay,

timeout

}: {

componentLoader: AsyncComponentLoader;

loadingComponent: Component;

errorComponent?: Component;

delay?: number;

timeout?: number;

}) => {

let resolveComponent: ComponentResolver;

return defineAsyncComponent({

// the loader function

loader: () => {

return new Promise((resolve) => {

resolveComponent = resolve as ComponentResolver;

});

},

loadingComponent: defineComponent({

setup() {

const elRef = ref();

async function loadComponent() {

const component = await componentLoader()

resolveComponent(component)

}

onMounted(async() => {

if (!('IntersectionObserver' in window)) {

await loadComponent();

return;

}

const observer = new IntersectionObserver((entries) => {

if (!entries[0].isIntersecting) {

return;

}

observer.unobserve(elRef.value);

await loadComponent();

});

observer.observe(elRef.value);

});

return () => {

return h('div', { ref: elRef }, loadingComponent);

};

},

}),

delay,

errorComponent,

timeout,

});

};

使用

<script setup lang="ts">

import Loading from './components/Loading.vue';

import { lazyLoadComponentIfVisible } from './utils';

const LazyLoaded = lazyLoadComponentIfVisible({

componentLoader: () => import('./components/HelloWorld.vue'),

loadingComponent: Loading,

});

</script>

<template>

<LazyLoaded />

</template>

问题引入

最近一直在看原型继承相关的东西,翻到这么一篇文章: 从 ES6 中的 extends 讲 js 原型链与继承

文中有一个点让我很感兴趣,箭头函数在继承过程中无法通过 super 关键字获取,这是为什么呢?

前置知识

MDN 上关于 super 的介绍

The super keyword is used to access and call functions on an object's parent - in MDN 大概有这么几个关键点:

- 子类中存在 constructor 方法的时候,需要调用 super 方法,并且需要在使用 this 关键字之前调用

- super 关键字可以用来调用父对象上的方法

- 可以使用 super 来调用父对象上的静态方法

- 不可以使用 delete 来删除 super 上的属性

- 不可以复写 super 对象上的只读属性

子类中是否必须主动调用 super 方法?

我的看法是不需要。 网上有些文章(比如这篇)写道:

因为若不执行 super,则 this 无法初始化。

我的个人理解是,this 是指代执行上下文环境的,不存在无法初始化的情况。更准确的说法是这样:如果不使用 super 方法,那么父类中的属性值无法进行初始化,如果这个时候子类通过 this 字段来访问了父类中的属性值,那么只能得到一个 undefined。至于为什么这么写编译的时候会报错?我的理解是,这应该是一种语法错误,而且是一种规范要求,ES6 语法的规范要求,这种要求并不是说会影响到代码的实际执行。举个栗子:

// typescript中一段简单的继承代码实现

class Parent {

name = 'parent';

func = function() {

console.log('func in parent called.');

}

}

class Child extends Parent {

age = 3;

func = function() {

console.log('age is: ', this.age); // 使用了this,不会报错

}

}

这段代码非常简单,在子类中使用了 this 关键字,编译时不会报错,也可以正常执行。然后我们进行一点修改,在子类中引入 constructor 方法

class Child extends Parent {

age = 3;

// error TS2377: Constructors for derived classes must contain a 'super' call.

constructor() {

}

func = function() {

console.log('age is: ', this.age);

}

}

可以看到,编译阶段已经开始报错了。在 typescript 的语法中,子类的 constructor 方法中不但需要调用 super 方法,而且必须在第一行代码就调用 super,否则都是会报错的。看下面这段代码:

class Child extends Parent {

age = 3;

constructor() {

console.log('First line in constructor without super method');

super(); // error TS2376: A 'super' call must be the first statement in the constructor when a class contains initialized properties or has parameter properties.

}

func = function() {

console.log('age is: ', this.age);

}

}

来,我们接着改

class Parent {

name = 'parent';

func = function() {

console.log('func in parent called.');

}

}

class Child extends Parent {

age = 3;

constructor() {

console.log('Show property of parent, name is: ', this.name); // error TS17009: 'super' must be called before accessing 'this' in the constructor of a derived class.

console.log('Show property of child, age is: ', this.age); // error TS17009: 'super' must be called before accessing 'this' in the constructor of a derived class.

super(); // error TS2376: A 'super' call must be the first statement in the constructor when a class contains initialized properties or has parameter properties.

console.log('Show property of parent, name is: ', this.name);

console.log('Show property of child, age is: ', this.age);

}

func = function() {

console.log('age is: ', this.age);

}

}

可以看到,编译期已经开始报各种错误了,不过这不重要,我们这里利用 typescript 的编译器(tsc)来进行编译,并查看编译后的代码内容:

var __extends = (this && this.__extends) || (function () {

var extendStatics = Object.setPrototypeOf ||

({ __proto__: [] } instanceof Array && function (d, b) { d.__proto__ = b; }) ||

function (d, b) { for (var p in b) if (b.hasOwnProperty(p)) d[p] = b[p]; };

return function (d, b) {

extendStatics(d, b);

function __() { this.constructor = d; }

d.prototype = b === null ? Object.create(b) : (__.prototype = b.prototype, new __());

};

})();

var Parent = (function () {

function Parent() {

this.name = 'parent';

this.func = function () {

console.log('func in parent called.');

};

}

return Parent;

}());

var Child = (function (_super) {

__extends(Child, _super);

function Child() {

var _this = this;

_this.age = 3;

_this.func = function () {

console.log('age is: ', this.age);

};

console.log('Show property of parent, name is: ', _this.name); // 输出undefined,因为此时子类的实例上还没有继承到父类的属性值

console.log('Show property of child, age is: ', _this.age); // 输出3,子类实例自己的属性值可以访问

_this = _super.call(this) || this; // 构造函数式的继承实现,这一步就是讲父类的属性值设置到子类实例上

console.log('Show property of parent, name is: ', _this.name); // 输出parent,此时子类的实例上经过上一步的继承,得到了父类的属性值

console.log('Show property of child, age is: ', _this.age); // 输出3,子类实例自己的属性值可以访问

return _this;

}

return Child;

}(Parent));

//# sourceMappingURL=demo.js.map

由此可以知道,在 ES6 中使用 extends 进行继承操作的过程中,

- 子类并非必须调用 super 方法,除非存在 constructor 方法

- 在 constructor 方法中应该首先调用 super 方法,这是语法要求,不过这不是必须的

- 在调用 super 方法之前,将无法通过 this 关键字来访问父类的属性(这里就可以解释其他文章中提到的 ‘若不执行 super,则 this 无法初始化’,更准确的说法应该是‘若不执行 super,则无法将父类的属性值初始化到当前子类实例上’)

子类中使用 super.prop 和 super[expr]的方式是如何访问父类的属性和方法?

我们直接来看代码吧,关键点都注释了的

class Parent {

public name = 'parent';

public static staticName = 'staticParent';

public static staticFunc() {

console.log('staticFunc called in parent.');

}

public arrowFunc = () => {

console.log('arrowFunc called in parent.');

}

public normalFunc() {

console.log('normalFunc called in parent.')

}

}

class Child extends Parent {

public static staticFunc() {

super.staticFunc();

console.log('staticFunc called in Child.');

}

arrowFunc = () => {

super.arrowFunc();

console.log('arrowFunc called in Child.');

}

normalFunc() {

super.normalFunc();

console.log('normalFunc called in Child.')

}

getName() {

console.log('parent name is: ', super.name);

console.log('parent staticName is: ', super.staticName);

console.log('child name is: ', this.name);

}

}

/** 编译后的代码 **/

var __extends = (this && this.__extends) || (function () {

var extendStatics = Object.setPrototypeOf ||

({ __proto__: [] } instanceof Array && function (d, b) { d.__proto__ = b; }) ||

function (d, b) { for (var p in b) if (b.hasOwnProperty(p)) d[p] = b[p]; };

return function (d, b) {

extendStatics(d, b);

function __() { this.constructor = d; }

d.prototype = b === null ? Object.create(b) : (__.prototype = b.prototype, new __());

};

})();

var Parent = (function () {

function Parent() {

this.name = 'parent';

this.arrowFunc = function () {

console.log('arrowFunc called in parent.');

};

}

// 编译后的静态方法可以存在于Parent类的内部

Parent.staticFunc = function () {

console.log('staticFunc called in parent.');

};

Parent.prototype.normalFunc = function () {

console.log('normalFunc called in parent.');

};

return Parent;

}());

Parent.staticName = 'staticParent'; // 编译后的静态属性依然存在于Parent类外

var Child = (function (_super) {

__extends(Child, _super);

function Child() {

var _this = _super !== null && _super.apply(this, arguments) || this;

_this.arrowFunc = function () { // 子类实例调用arrowFunc的时候会报错,因为_super.prototype上是不存在arrowFunc方法的

_super.prototype.arrowFunc.call(_this); // Uncaught TypeError: Cannot read property 'call' of undefined

console.log('arrowFunc called in Child.');

};

return _this;

}

Child.staticFunc = function () {

_super.staticFunc.call(this); // super可以正常访问父类的静态方法

console.log('staticFunc called in Child.');

};

Child.prototype.normalFunc = function () {

_super.prototype.normalFunc.call(this);

console.log('normalFunc called in Child.');

};

Child.prototype.getName = function () {

console.log('parent name is: ', _super.prototype.name); // 输出undefined, 父类原型(_super.prototype)上不存在name属性

console.log('parent staticName is: ', _super.prototype.staticName); // 输出undefined,super无法正常访问父类的静态属性

console.log('child name is: ', this.name); // 输出parent,这是子类实例上的属性,继承自父类

};

return Child;

}(Parent));

//# sourceMappingURL=demo.js.map

这里再顺嘴提一句,关于静态属性和静态方法的区别。为什么在子类中通过 super 关键字来获取父类的静态方法经过编译后是_super.staticFunc,而获取静态属性依然是_super.prototype.staticName,从原型上获取导致获取失败呢?这个问题目前我还没有找到答案,希望有知道的小伙伴可以不吝指教。 不过我倒是搜到一些其他相关内容。 Class 的静态属性和实例属性

因为 ES6 明确规定,Class 内部只有静态方法,没有静态属性。

虽然这种规定从 ES7 开始得到了修正,我们目前已经可以将静态属性写在 Class 的内部,但是经过编译之后可以发现,静态属性依然存在于类的实现的外部。

var Parent = (function () {

function Parent() {

this.name = 'parent';

this.arrowFunc = function () {

console.log('arrowFunc called in parent.');

};

}

// 编译后的静态方法可以存在于Parent类的内部

Parent.staticFunc = function () {

console.log('staticFunc called in parent.');

};

Parent.prototype.normalFunc = function () {

console.log('normalFunc called in parent.');

};

return Parent;

}());

Parent.staticName = 'staticParent'; // 编译后的静态属性依然存在于Parent类外

回到问题本身

问:箭头函数在继承过程中无法通过 super 关键字获取,这是为什么呢? 答:因为子类中使用 super.prop 和 super[expr]的方式获取的是父类原型(prototype)上的方法,静态方法除外。

参考资料

从 ES6 中的 extends 讲 js 原型链与继承 React ES6 class constructor super() Class 的静态属性和实例属性

Require 和 import 和 export 等

这篇文章主要给大家介绍了关于 javascript 中 require 、 import 与 export

的相关资料,文中通过示例代码介绍的非常详细,对打击大的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧。

前言

本文主要给大家介绍了关于 javascript 中 require 、 import 与 export 的相关内容,分享出来供大家参考学习,下面话不多说了,来一起看看详细的介绍吧。

为什么有模块概念

理想情况下,开发者只需要实现核心的业务逻辑,其他都可以加载别人已经写好的模块。

但是, Javascript 不是一种模块化编程语言,在 es6 以前,它是不支持”类”( class ),所以也就没有”模块”( module )了。

require 时代

Javascript 社区做了很多努力,在现有的运行环境中,实现”模块”的效果。

原始写法

模块就是实现特定功能的一组方法。 只要把不同的函数(以及记录状态的变量)简单地放在一起,就算是一个模块。

function m1() {

//...

}

function m2() {

//...

}

上面的函数 m1() 和 m2() ,组成一个模块。使用的时候,直接调用就行了。

这种做法的缺点很明显:”污染”了全局变量,无法保证不与其他模块发生变量名冲突,而且模块成员之间看不出直接关系。

对象写法

为了解决上面的缺点,可以把模块写成一个对象,所有的模块成员都放到这个对象里面

var module1 = new Object({

_count: 0,

m1: function () {

//...

},

m2: function () {

//...

},

});

上面的函数 m1() 和 m2(),都封装在 module 1 对象里。使用的时候,就是调用这个对象的属性

module1.m1();

这样的写法会暴露所有模块成员,内部状态可以被外部改写。比如,外部代码可以直接改变内部计数器的值。

module._count = 1;

立即执行函数写法(闭包缓存)

使用”立即执行函数”(Immediately-Invoked Function Expression,IIFE),可以达到不暴露私有成员的目的

var module = (function () {

var _count = 0;

var m1 = function () {

alert(_count);

};

var m2 = function () {

alert(_count + 1);

};

return {

m1: m1,

m2: m2,

};

})();

使用上面的写法,外部代码无法读取内部的 _count 变量。

console.info(module._count); //undefined

module 就是 Javascript 模块的基本写法。

主流模块规范

在 es6 以前,还没有提出一套官方的规范,从社区和框架推广程度而言,目前通行的 javascript 模块规范有两种: CommonJS 和 AMD

CommonJS 规范

2009 年,美国程序员 Ryan Dahl 创造了 node.js 项目,将 javascript 语言用于服务器端编程。

这标志”Javascript 模块化编程”正式诞生。前端的复杂程度有限,没有模块也是可以的,但是在服务器端,一定要有模块,与操作系统和其他应用程序互动,否则根本没法编程。

node 编程中最重要的思想之一就是模块,而正是这个思想,让 JavaScript 的大规模工程成为可能。模块化编程在 js 界流行,也是基于此,随后在浏览器端, requirejs

和 seajs 之类的工具包也出现了,可以说在对应规范下, require 统治了 ES6 之前的所有模块化编程,即使现在,在 ES6 module 被完全实现之前,还是这样。

在 CommonJS 中,暴露模块使用 module . exports 和 exports ,很多人不明白暴露对象为什么会有两个,后面会介绍区别

在 CommonJS 中,有一个全局性方法 require() ,用于加载模块。假定有一个数学模块 math.js,就可以像下面这样加载。

var math = require("math");

然后,就可以调用模块提供的方法:

var math = require("math");

math.add(2, 3); // 5

正是由于 CommonJS 使用的 require 方式的推动,才有了后面的 AMD 、 CMD 也采用的 require 方式来引用模块的风格

AMD 规范

有了服务器端模块以后,很自然地,大家就想要客户端模块。而且最好两者能够兼容,一个模块不用修改,在服务器和浏览器都可以运行。

但是,由于一个重大的局限,使得 CommonJS 规范不适用于浏览器环境。还是上一节的代码,如果在浏览器中运行,会有一个很大的问题

var math = require("math");

math.add(2, 3);

第二行 math.add(2, 3) ,在第一行 require('math') 之后运行,因此必须等 math.js 加载完成。也就是说,如果加载时间很长,整个应用就会停在那里等。

这对服务器端不是一个问题,因为所有的模块都存放在本地硬盘,可以同步加载完成,等待时间就是硬盘的读取时间。但是,对于浏览器,这却是一个大问题,因为模块都放在服务器端,等待时间取决于网速的快慢,可能要等很长时间,浏览器处于”假死”状态。

因此,浏览器端的模块,不能采用”同步加载”( synchronous ),只能采用”异步加载”( asynchronous )。这就是 AMD 规范诞生的背景。

AMD 是 Asynchronous Module Definition

的缩写,意思就是”异步模块定义”。它采用步方式加载模块,模块的加载不影响它后面语句的运行。所有依赖这个模块的语句,都定义在一回调函数中,等到加载完成之后,这个回调函数才会运行。

模块必须采用特定的 define() 函数来定义。

define(id?, dependencies?, factory);

- id:字符串,模块名称(可选)

- dependencies: 是我们要载入的依赖模块(可选),使用相对路径。,注意是数组格式

- factory: 工厂方法,返回一个模块函数

如果一个模块不依赖其他模块,那么可以直接定义在 define() 函数之中。

// math.js

define(function () {

var add = function (x, y) {

return x + y;

};

return {

add: add,

};

});

如果这个模块还依赖其他模块,那么 define() 函数的第一个参数,必须是一个数组,指明该模块的依赖性。

define(["Lib"], function (Lib) {

function foo() {

Lib.doSomething();

}

return {

foo: foo,

};

});

当 require() 函数加载上面这个模块的时候,就会先加载 Lib.js 文件。

AMD 也采用 require() 语句加载模块,但是不同于 CommonJS ,它要求两个参数:

require([module], callback);

第一个参数 [module] ,是一个数组,里面的成员就是要加载的模块;第二个参数 callback ,则是加载成功之后的回调函数。如果将前面的代码改写成 AMD 形式,就是下面这样:

require(["math"], function (math) {

math.add(2, 3);

});

math.add() 与 math 模块加载不是同步的,浏览器不会发生假死。所以很显然, AMD 比较适合浏览器环境。

目前,主要有两个 Javascript 库实现了 AMD 规范:require.js 和 curl.js。

CMD 规范

CMD (Common Module Definition), 是 seajs 推崇的规范, CMD 则是依赖就近,用的时候再 require 。它写起来是这样的:

define(function (require, exports, module) {

var clock = require("clock");

clock.start();

});

CMD 与 AMD 一样,也是采用特定的 define() 函数来定义,用 require 方式来引用模块

define(id?, dependencies?, factory);

- id:字符串,模块名称(可选)

- dependencies: 是我们要载入的依赖模块(可选),使用相对路径。,注意是数组格式

- factory: 工厂方法,返回一个模块函数

define("hello", ["jquery"], function (require, exports, module) {

// 模块代码

});

如果一个模块不依赖其他模块,那么可以直接定义在 define() 函数之中。

define(function (require, exports, module) {

// 模块代码

});

注意:带 id 和 dependencies 参数的 define 用法不属于 CMD 规范,而属于 Modules/Transport 规范。

CMD 与 AMD 区别

AMD和 CMD 最大的区别是对依赖模块的执行时机处理不同,而不是加载的时机或者方式不同,二者皆为异步加载模块。

AMD 依赖前置, js 可以方便知道依赖模块是谁,立即加载;

而 CMD 就近依赖,需要使用把模块变为字符串解析一遍才知道依赖了那些模块,这也是很多人诟病 CMD 的一点,牺牲性能来带来开发的便利性,实际上解析模块用的时间短到可以忽略。

现阶段的标准

ES6 标准发布后, module 成为标准,标准使用是以 export 指令导出接口,以 import 引入模块,但是在我们一贯的 node 模块中,我们依然采用的是

CommonJS 规范,使用 require 引入模块,使用 module.exports 导出接口。

export 导出模块

export 语法声明用于导出函数、对象、指定文件(或模块)的原始值。

注意:在 node 中使用的是 exports ,不要混淆了

export 有两种模块导出方式:命名式导出(名称导出)和默认导出(定义式导出),命名式导出每个模块可以多个,而默认导出每个模块仅一个。

export { name1, name2, …, nameN };

export { variable1 as name1, variable2 as name2, …, nameN };

export let name1, name2, …, nameN; // also var

export let name1 = …, name2 = …, …, nameN; // also var, const

export default expression;

export default function (…) { … } // also class, function*

export default function name1(…) { … } // also class, function*

export { name1 as default, … };

export * from …;

export { name1, name2, …, nameN } from …;

export { import1 as name1, import2 as name2, …, nameN } from …;

name1… nameN-导出的“标识符”。导出后,可以通过这个“标识符”在另一个模块中使用import引用default-设置模块的默认导出。设置后import不通过“标识符”而直接引用默认导入- -继承模块并导出继承模块所有的方法和属性

as-重命名导出“标识符”from-从已经存在的模块、脚本文件…导出

命名式导出

模块可以通过 export 前缀关键词声明导出对象,导出对象可以是多个。这些导出对象用名称进行区分,称之为命名式导出。

export { myFunction }; // 导出一个已定义的函数

export const foo = Math.sqrt(2); // 导出一个常量

我们可以使用 * 和 from 关键字来实现的模块的继承:

export * from "article";

模块导出时,可以指定模块的导出成员。导出成员可以认为是类中的公有对象,而非导出成员可以认为是类中的私有对象:

var name = "IT笔录";

var domain = "http://itbilu.com";

export { name, domain }; // 相当于导出{name:name,domain:domain}

模块导出时,我们可以使用 as 关键字对导出成员进行重命名:

var name = "IT笔录";

var domain = "http://itbilu.com";

export { name as siteName, domain };

注意:下面的语法有严重错误的情况:

// 错误演示

export 1; // 绝对不可以

var a = 100;

export a;

export 在导出接口的时候,必须与模块内部的变量具有一一对应的关系。直接导出 1 没有任何意义,也不可能在 import 的时候有一个变量与之对应

export a 虽然看上去成立,但是 a 的值是一个数字,根本无法完成解构,因此必须写成 export {a} 的形式。即使 a 被赋值为一个 function

,也是不允许的。而且,大部分风格都建议,模块中最好在末尾用一个 export 导出所有的接口,例如:

export { fun as default, a, b, c };

默认导出

默认导出也被称做定义式导出。命名式导出可以导出多个值,但在在 import

引用时,也要使用相同的名称来引用相应的值。而默认导出每个导出只有一个单一值,这个输出可以是一个函数、类或其它类型的值,这样在模块 import 导入时也会很容易引用。

export default function() {}; // 可以导出一个函数

export default class(){}; // 也可以出一个类

命名式导出与默认导出

默认导出可以理解为另一种形式的命名导出,默认导出可以认为是使用了 default 名称的命名导出。

下面两种导出方式是等价的:

const D = 123;

export default D;

export { D as default };

export 使用示例

使用名称导出一个模块时:

// "my-module.js" 模块

export function cube(x) {

return x * x * x;

}

const foo = Math.PI + Math.SQRT2;

export { foo };

在另一个模块(脚本文件)中,我们可以像下面这样引用:

import { cube, foo } from "my-module";

console.log(cube(3)); // 27

console.log(foo); // 4.555806215962888

使用默认导出一个模块时:

// "my-module.js"模块

export default function (x) {

return x * x * x;

}

在另一个模块(脚本文件)中,我们可以像下面这样引用,相对名称导出来说使用更为简单:

// 引用 "my-module.js"模块

import cube from "my-module";

console.log(cube(3)); // 27

import 引入模块

import 语法声明用于从已导出的模块、脚本中导入函数、对象、指定文件(或模块)的原始值。

import 模块导入与 export 模块导出功能相对应,也存在两种模块导入方式:命名式导入(名称导入)和默认导入(定义式导入)。

import 的语法跟 require 不同,而且 import 必须放在文件的最开始,且前面不允许有其他逻辑代码,这和其他所有编程语言风格一致。

import defaultMember from "module-name";

import * as name from "module-name";

import { member } from "module-name";

import { member as alias } from "module-name";

import { member1 , member2 } from "module-name";

import { member1 , member2 as alias2 , [...] } from "module-name";

import defaultMember, { member [ , [...] ] } from "module-name";

import defaultMember, * as name from "module-name";

import "module-name";

- name-从将要导入模块中收到的导出值的名称

- member, memberN-从导出模块,导入指定名称的多个成员

- defaultMember-从导出模块,导入默认导出成员

- alias, aliasN-别名,对指定导入成员进行的重命名

- module-name-要导入的模块。是一个文件名

- as-重命名导入成员名称(“标识符”)

- from-从已经存在的模块、脚本文件等导入

命名式导入

我们可以通过指定名称,就是将这些成员插入到当作用域中。导出时,可以导入单个成员或多个成员:

注意:花括号里面的变量与 export 后面的变量一一对应

import { myMember } from "my-module";

import { foo, bar } from "my-module";

通过*符号,我们可以导入模块中的全部属性和方法。当导入模块全部导出内容时,就是将导出模块(my-module.js)所有的导出绑定内容,插入到当前模块(myModule)的作用域中:

import * as myModule from "my-module";

导入模块对象时,也可以使用 as 对导入成员重命名,以方便在当前模块内使用:

import {reallyReallyLongModuleMemberName as shortName} from "my-module";

导入多个成员时,同样可以使用别名:

import {reallyReallyLongModuleMemberName as shortName, anotherLongModuleName as short} from "my-module";

导入一个模块,但不进行任何绑定:

import "my-module";

默认导入

在模块导出时,可能会存在默认导出。同样的,在导入时可以使用 import 指令导出这些默认值。

直接导入默认值:

import myDefault from "my-module";

也可以在命名空间导入和名称导入中,同时使用默认导入:

import myDefault, * as myModule from "my-module"; // myModule 做为命名空间使用

或

import myDefault, {foo, bar} from "my-module"; // 指定成员导入

import 使用示例

// --file.js--

function getJSON(url, callback) {

let xhr = new XMLHttpRequest();

xhr.onload = function () {

callback(this.responseText)

};

xhr.open("GET", url, true);

xhr.send();

}

export function getUsefulContents(url, callback) {

getJSON(url, data => callback(JSON.parse(data)));

}

// --main.js--

import { getUsefulContents } from "file";

getUsefulContents("http://itbilu.com", data => {

doSomethingUseful(data);

});

default 关键字

// d.js

export default function() {}

// 等效于:

function a() {};

export {a as default};

在 import 的时候,可以这样用:

import a from './d';

// 等效于,或者说就是下面这种写法的简写,是同一个意思

import {default as a} from './d';

这个语法糖的好处就是 import 的时候,可以省去花括号{}。

简单的说,如果 import 的时候,你发现某个变量没有花括号括起来(没有*号),那么你在脑海中应该把它还原成有花括号的 as 语法。

所以,下面这种写法你也应该理解了吧:

import $,{each,map} from 'jquery';

import 后面第一个$是{defalut as $}的替代写法。

as 关键字

as 简单的说就是取一个别名,export 中可以用,import 中其实可以用:

// a.js

var a = function() {};

export {a as fun};

// b.js

import {fun as a} from './a';

a();

上面这段代码,export 的时候,对外提供的接口是 fun,它是 a.js 内部 a 这个函数的别名,但是在模块外面,认不到 a,只能认到 fun。

import 中的 as 就很简单,就是你在使用模块里面的方法的时候,给这个方法取一个别名,好在当前的文件里面使用。之所以是这样,是因为有的时候不同的两个模块可能通过相同的接口,比如有一个 c.js 也通过了 fun 这个接口:

// c.js

export function fun() {};

如果在 b.js 中同时使用 a 和 c 这两个模块,就必须想办法解决接口重名的问题,as 就解决了。

CommonJS 中 module.exports 与 exports 的区别

Module.exports

The module.exports object is created by the Module system. Sometimes this is not acceptable; many want their module to be an instance of some class. To do this, assign the desired export object to module.exports. Note that assigning the desired object to exports will simply rebind the local exports variable, which is probably not what you want to do.

译文:module.exports 对象是由模块系统创建的。 有时这是难以接受的;许多人希望他们的模块成为某个类的实例。 为了实现这个,需要将期望导出的对象赋值给 module.exports。 注意,将期望的对象赋值给 exports 会简单地重新绑定到本地 exports 变量上,这可能不是你想要的。

Module.exports

The exports variable is available within a module's file-level scope, and is assigned the value of module.exports before the module is evaluated. It allows a shortcut, so that module.exports.f = … can be written more succinctly as exports.f = …. However, be aware that like any variable, if a new value is assigned to exports, it is no longer bound to module.exports:

译文:exports 变量是在模块的文件级别作用域内有效的,它在模块被执行前被赋于 module.exports 的值。它有一个快捷方式,以便 module.exports.f = …可以被更简洁地写成 exports.f = …。 注意,就像任何变量,如果一个新的值被赋值给 exports,它就不再绑定到 module.exports(其实是 exports.属性会自动挂载到没有命名冲突的 module.exports.属性)

从 Api 文档上面的可以看出,从 require 导入方式去理解,关键有两个变量(全局变量 module.exports,局部变量 exports)、一个返回值(module.exports)

function require(...) {

var module = { exports: {} };

((module, exports) => {

// 你的被引入代码 Start

// var exports = module.exports = {}; (默认都有的)

function some_func() {};

exports = some_func;

// 此时,exports不再挂载到module.exports,

// export将导出{}默认对象

module.exports = some_func;

// 此时,这个模块将导出some_func对象,覆盖exports上的some_func

// 你的被引入代码 End

})(module, module.exports);

// 不管是exports还是module.exports,最后返回的还是module.exports

return module.exports;

}

demo.js:

console.log(exports); // {}

console.log(module.exports); // {}

console.log(exports === module.exports); // true

console.log(exports == module.exports); // true

console.log(module);

/**

Module {

id: '.',

exports: {},

parent: null,

filename: '/Users/larben/Desktop/demo.js',

loaded: false,

children: [],

paths:

[ '/Users/larben/Desktop/node_modules',

'/Users/larben/node_modules',

'/Users/node_modules',

'/node_modules' ] }

*/

注意

每个 js 文件一创建,都有一个 var exports = module.exports = {} , 使 exports 和 module.exports 都指向一个空对象。

module.exports 和 exports 所指向的内存地址相同

总结

以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作能带来一定的帮助,如果有疑问大家可以留言交流,谢谢大家对脚本之家的支持。

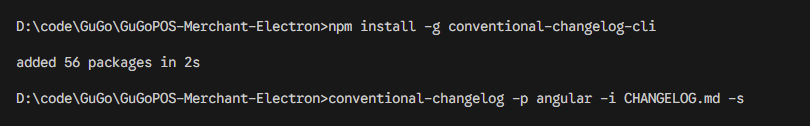

代码不规范,同事两行泪

- 可读性差

- 维护困难

- 变更历史不透明

- 自动化工具的不兼容

如何统一代码风格,规范提交呢呢? 推荐使用 ESLint + Prettier + husky + lint-staged

大部分是以前写的东西,最新的使用方法要参考官方文档使用!!!

另外还有一些搭建项目时大概率会用到的一些东西。(未来得及做讲解,详细参考最新的官方文档)

- eslint (eslint) JavaScript 代码检测工具,检测并提示错误或警告信息

- prettier (prettier) 代码自动化格式化工具,更好的代码风格效果

- husky (husky) Git hooks 工具, 可以在执行 git 命令时,执行自定义的脚本程序

- lint-staged (lint-staged) 对暂存区 (git add) 文件执行脚本 检测 校验

- Commitizen (commitizen) 检测 git commit 内容是否符合定义的规范

- conventional-changelog (conventional-changelog)

- eslint-config-prettier (eslint-config-prettier) 解决 eslint 和 prettier 冲突

- 多环境管理(react-native-dotenv,react-native-config 等)dotenv

- 状态管理轻简化redux-toolkit

- 表单校验Yup,表单控件react-hook-form

- 自动收集国际化i18next-scanner, vscode 插件i18n Ally

- 屏幕适配方案size-matters

- 跨平台协作,环境变量设置cross-env

ESlint

eslint 是一个代码检测工具,用于检测代码中潜在的问题和错误,作用提高代码质量和规范。

安装步骤:

1、安装 eslint

npm install eslint

2、快速构建 eslint 配置文件

npm init @eslint/config

参考如下 gif 操作:

执行完成后,自动生成 eslint 配置文件.eslintrc.js 可在 .eslintrc.js 中配置 rules 定义校验规则

rules: {

indent: ['error', 4], // 用于指定代码缩进的方式,这里配置为使用四个空格进行缩进。

'linebreak-style': [0, 'error', 'windows'], // 用于指定换行符的风格,这里配置为使用 Windows 风格的换行符(\r\n)。

quotes: ['error', 'single'], // 用于指定字符串的引号风格,这里配置为使用单引号作为字符串的引号。

semi: ['error', 'always'], //用于指定是否需要在语句末尾添加分号,这里配置为必须始终添加分号。

'@typescript-eslint/no-explicit-any': ['off'] // 用于配置 TypeScript 中的 "any" 类型的使用规则,这里配置为关闭禁止显式使用 "any" 类型的检查。

}

husky:

husky 是一个 Git 钩子(Git hooks)工具,它可以让你在 Git 事件发生时执行脚本,进行代码格式化、测试等操作。

常见的钩子

pre-commit:在执行 Gitcommit命令之前触发,用于在提交代码前进行代码检查、格式化、测试等操作。commit-msg:在提交消息(commit message)被创建后,但提交操作尚未完成之前触发,用于校验提交消息的格式和内容。pre-push:在执行 Gitpush命令之前触发,用于在推送代码前进行额外检查、测试等操作。

具体的使用步骤如下:

安装

注意!官方文档更新了使用方式,请参考官方文档!

- 在项目根目录下运行以下命令安装 husky:

npm install husky --save-dev

- 启用 git 钩子 输入以下命令

npm pkg set scripts.prepare="husky install"

安装成功后会在 package.json 文件中 script 中生成命令

注意!如为自动生成需手动添加,将以下内容粘贴到 package.json 文件中

// package.json

{

"scripts": {

"prepare": "husky install"

}

}

- 创建

.husky目录,执行如下代码

npm run prepare

如图,执行成功后,项目中生成一个 .husky 目录

注意!如未生成 .husky 目录,推荐使用命令

npx husky install

创建 Git 挂钩

pre-commit

在 Git 提交之前做eslint 语法校验 。

1、创建钩子脚本文件

npx husky add .husky/pre-commit "npm test"

执执行成功,.husky 目录多出一个 pre-commit 文件

M.png)

注意!

window电脑输入后,可能会报错如下

Usage:

husky install [dir] (default: .husky)

husky uninstall

husky set|add <file> [cmd]

解决方式,删除 "npm test" 重新执行

npx husky add .husky/commit-msg

2、配置代码检测

git 提交前,执行 pre-commit 钩子脚本,进行校验代码语法、格式修复等操作。

1、打开 pre-commit 文件,内容如下:

#!/usr/bin/env sh

. "$(dirname -- "$0")/_/husky.sh"

2、下方代码添加到 pre-commit 文件中。lint-staged模块, 用于对 git 暂存区检测

npx --no-install lint-staged

npx --no-install lint-staged是一个命令,用于在不安装 lint-staged 的情况下运行该工具。npx --no-install命令用于从远程下载并执行指定的命令。

lint-staged

- 作用:lint-staged 可以让你在 Git 暂存(staged)区域中的文件上运行脚本,通常用于在提交前对代码进行格式化、静态检查等操作。

- 使用方式:你可以在项目中使用 lint-staged 配合 husky 钩子来执行针对暂存文件的脚本。具体的使用步骤如下:

在项目根目录下运行以下命令安装 lint-staged:

npm install lint-staged --save-dev

在 package.json 文件中添加以下配置:

{

"lint-staged": {

// src/**/*.{js,jsx,ts,tsx} 校验暂存区、指定目录下的文件类型

// 校验命令,执行 eslint 、prettier

"src/**/*.{js,jsx,ts,tsx}": ["prettier --write", "eslint --fix"]

}

}

"src/**/*.{js,jsx,ts,tsx}"是指定要针对的暂存文件模式,你可以根据自己的项目需求来配置。["prettier --write","eslint --fix"]为校验命令,可执行 eslint 、prettier 等规则

prettier

prettier 是一个代码格式化工具。prettier 与上述 husky 和 lint-staged 搭配使用,可以在提交代码之前自动格式化代码。具体的使用步骤如下:

在项目根目录下运行以下命令安装 prettier:

npm install prettier --save-dev

建 .prettierrc.js 文件,并定义你想要的代码样式,例如:

module.exports = {

semi: true, //强制在语句末尾使用分号。

trailingComma: "none", //不允许在多行结构的最后一个元素或属性后添加逗号。

singleQuote: true, //使用单引号而不是双引号来定义字符串。

printWidth: 120, //指定每行代码的最大字符宽度,超过这个宽度的代码将被换行

tabWidth: 4, //指定一个制表符(Tab)等于多少个空格。

};

这里的配置选项根据你的需求定义,具体选项可以参考 prettier 文档。 在 lint-staged 的配置中添加 "prettier --write",例如:

{

"lint-staged": {

// src/**/*.{js,jsx,ts,tsx} 校验暂存区、指定目录下的文件类型

// 校验命令,执行 eslint 、prettier

"src/**/*.{js,jsx,ts,tsx}": ["prettier --write", "eslint --fix"]

}

}

这样当你进行 GIT 提交操作时,lint-staged 将自动运行 prettier 来格式化符合规则的文件。

配置 ctrl + s ,自动保存功能

第一种,在 vscode 设置里面配置 点击 Vscode 的设置=>工作区=>文本编辑器

安装步骤

Commitizen

是一个命令行工具,用于以一致的方式编写规范的提交消息。在使用 Commitizen 之前,你需要安装 Commitizen 及其适配器。

cz-conventional-changelog

是 Commitizen 的一个适配器,它实现了符合约定式提交(Conventional Commits)规范的提交消息。该规范定义了提交消息的格式和结构,并推荐了一些常用的提交类型和范围。

安装和使用步骤:

1、确保你的项目已经初始化并安装了 npm 或 yarn。 2、打开命令行终端,并在项目根目录下运行以下命令来安装 commitizen 和 cz-conventional-changelog:

使用 npm:

npm install --save-dev commitizen cz-conventional-changelog

使用 yarn:

yarn add --dev commitizen cz-conventional-changelog

3、安装完成后,在 package.json 中添加一个 config.commitizen 的字段,并设置它的值为 cz-conventional-changelog。 示例如下:

"config": {

"commitizen": {

"path": "cz-conventional-changelog"

}

}

在 package.json 中的 scripts 字段中添加一个 commit 的命令。 示例如下:

"scripts": {

"commit": "git-cz"

}

4、这将允许你使用 npm run commit 或 yarn commit 命令来进行交互式的提交。

现在,你可以使用 npm run commit 或 yarn commit 命令来进行提交。这将打开一个交互式的界面,引导你填写提交消息。

案例如下: 1、提交修改文件

git add .

2、开始交互式提交,填写规范信息

npm run commit

3、选择提交类型

? Select the type of change that you're committing: (Use arrow keys)

> feat: A new feature //新功能

fix: A bug fix //错误修复

docs: Documentation only changes //仅文档更改

style: [样式]Changes that do not affect the meaning of the code (white-space, formatting, missing semi-colons, etc)

refactor: [重构] A code change that neither fixes a bug nor adds a feature

perf: A code change that improves performance

test: Adding missing tests or correcting existing tests

4、根据提示填写内容,可选择空格跳过

? What is the scope of this change // 此更改的范围是什么

? Write a short, imperative tense description of the change//【必填】 简短的描述这个变化

? Provide a longer description of the change//提供变更的详细说明:

? Are there any breaking changes? //有什么突破性的变化吗?【y/n】

? Does this change affect any open issues? (y/N) //此更改是否会影响任何悬而未决的问题(是/否)

// 完成提交,输出打印日志:

[master 2cf55e0] docs: 修改commitzen文档

1 file changed, 2 insertions(+), 2 deletions(-)

当你完成提交消息后,Commitizen 会自动生成符合规范的提交消息,并将其添加到 Git commit 中。 根据 cz-conventional-changelog 的规范,提交消息需要包括类型(type)、范围(scope)、简短的描述(subject)和可选的详细描述(body)。

参考 https://blog.csdn.net/fightingLKP/article/details/126695679

commitlint

参考公认规范

- 作用:commitlint 用于校验 Git 提交信息的格式是否符合预定义的规范。

- 使用方式:你可以在项目中使用 commitlint 来规范提交信息的格式,例如使用约定式提交(Conventional Commits)的格式。具体的使用步骤如下:

在项目根目录下运行以下命令安装 commitlint:

npm install @commitlint/cli --save-dev

在项目根目录下创建 commitlint.config.js 文件,并添加以下配置:

module.exports = {

extends: ["@commitlint/config-conventional"],

};

这里使用了 @commitlint/config-conventional 包提供的预定义配置,可根据需要自定义配置。你还可以在配置文件中定义自己的规则。

在 package.json 文件中添加以下配置:

{

"scripts": {

"commitmsg": "commitlint -E HUSKY_GIT_PARAMS"

}

}

修改 husky 的配置,添加 "commit-msg" 钩子事件如下:

{

"husky": {

"hooks": {

"commit-msg": "npm run commitmsg",

"...": "..."

}

}

}

或者在.husky 文件夹下新建 commit-msg 文件写入npm run commitmsg(推荐)

这样当你进行提交信息时,commitlint 将自动校验提交信息的格式是否符合预定义规范,并给出相应的提示和错误。

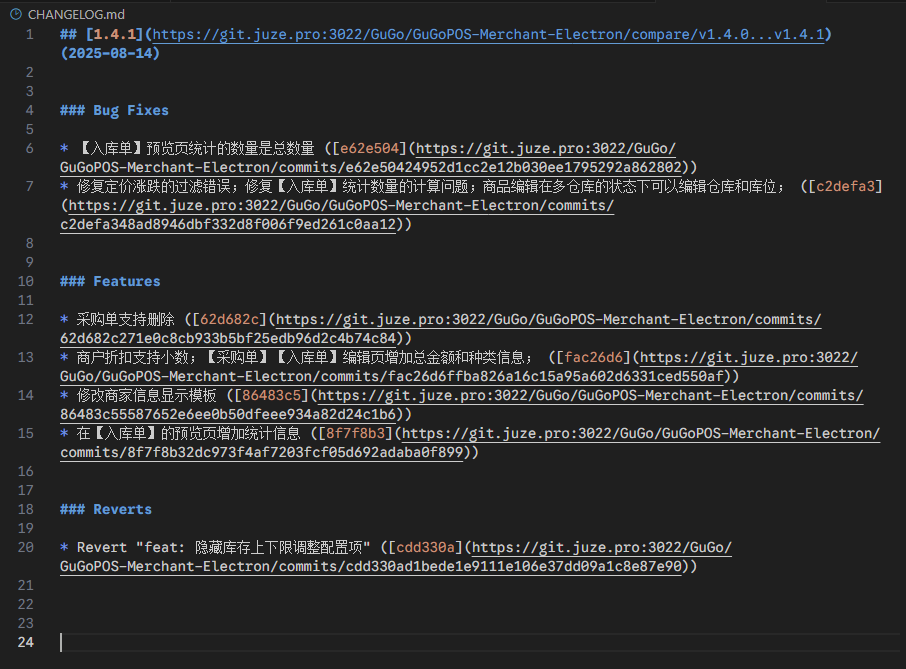

根据 commit 内容自动生成 CHANGELOG,更新发版内容

解决 eslint 和 prettier 冲突

分享

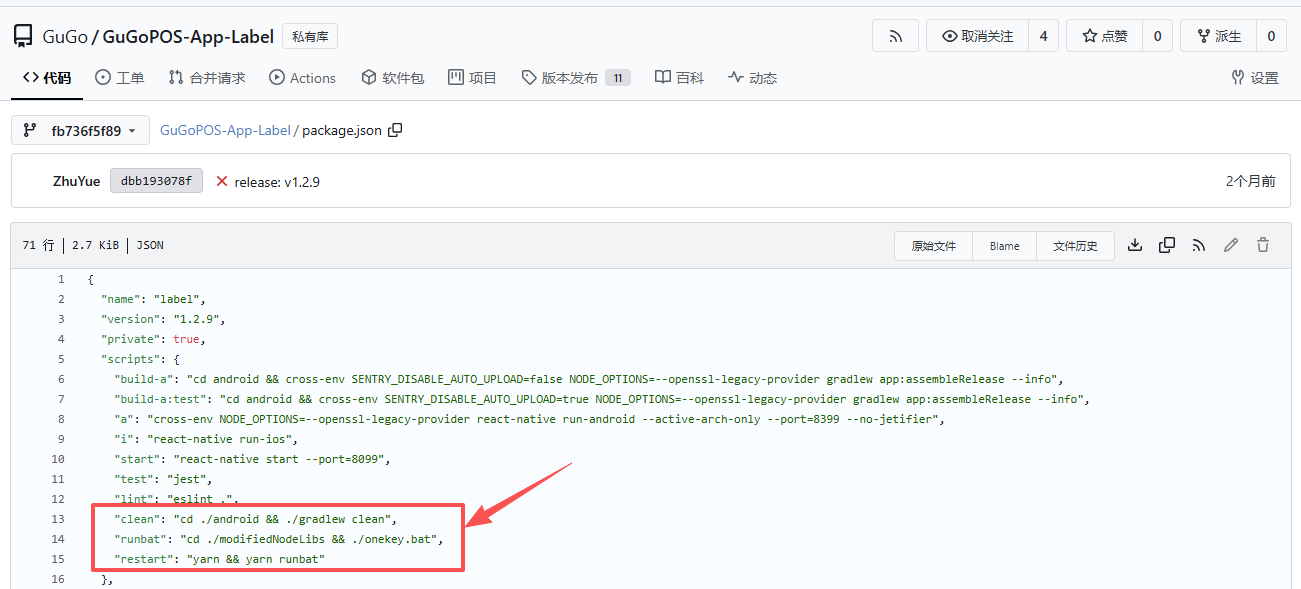

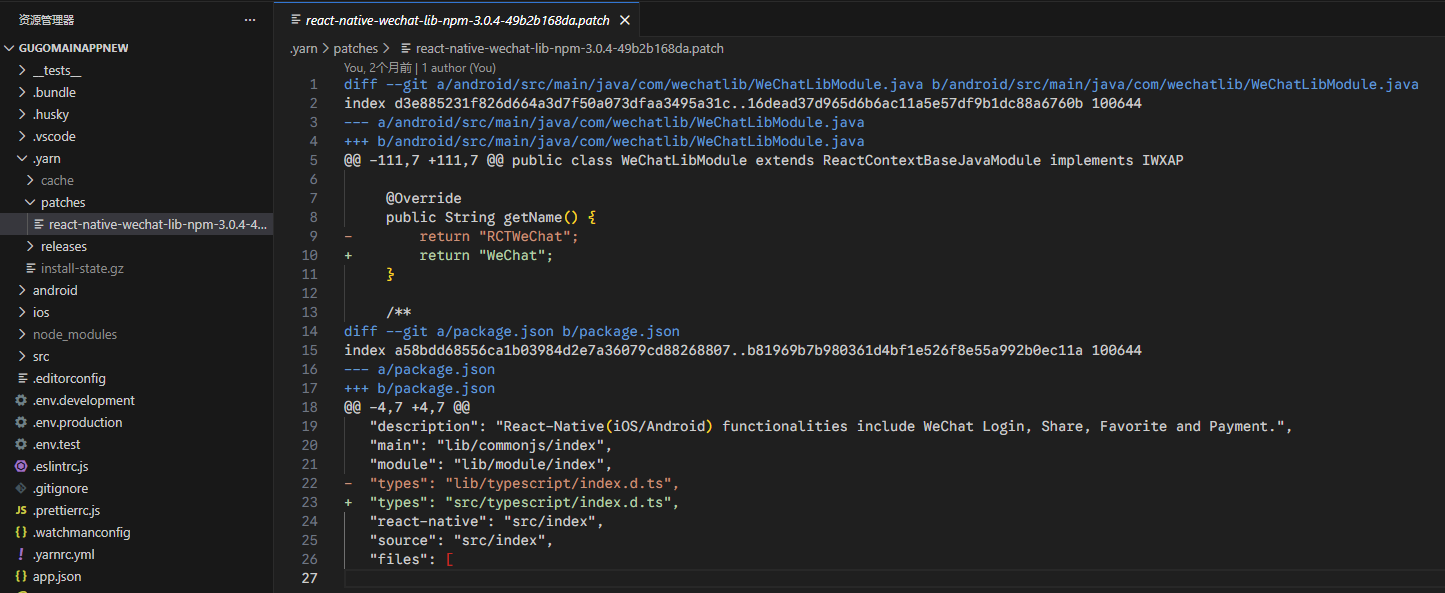

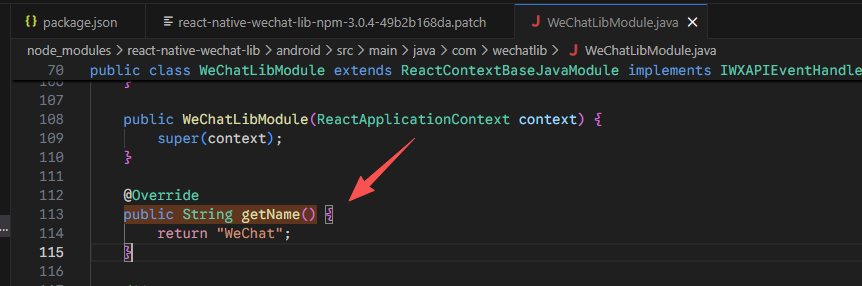

1、优雅的修改第三方库

小朋友,你是否有很多问号?

在第三方库有 bug,或者不能满足我们的使用需求的情况下。

PR 合并太慢,想立刻用上,但又要等发布?

等等等各种原因的情况下

如何优雅的修改第三方库?

1、 patch-package

2、 yarn v2+

yarn patch <package>

D:\code\GuGo\GuGoMainAppNew>yarn patch react

➤ YN0000: Package react@npm:19.0.0 got extracted with success!

➤ YN0000: You can now edit the following folder: C:\Users\utopia\AppData\Local\Temp\xfs-434126c1\user

➤ YN0000: Once you are done run yarn patch-commit -s "C:\Users\utopia\AppData\Local\Temp\xfs-434126c1\user" and Yarn will store a patchfile based on your changes.

➤ YN0000: Done in 0s 58ms

运行之后,会创建一个工作空间,然后完成修改之后

yarn patch-commit -s "xxxx"

之后会生成一个 patch 文件(需要通过版本管理提交到代码仓库)

以后运行 yarn install 就会自动打上 patch

以上两个方案都是基于 diff patch 的,方案 1 更通用一点,方案 2 依赖 yarn v2 的功能。

当然也完全可以基于 git 的 diff patch 来实现,但是还是需要手动执行 patch,以上两个方案都是会自动在 install 的阶段打上 patch ,完全无感,但是还是建议补全文档。

2、如何优雅的实现一个健壮的列表页面

前提条件:

- 设计规范统一

- 接口规范统一、幂等

- 业务逻辑大致相似

需求:

- 带

loading,error - 带分页可控分页参数

- 返回页面之后自动重加载

步骤

1、 先实现列表页的大致 UI 框架,通过 Props 修改可修改的部分。

2、 思考数据的处理方式

观察如下代码,是否有问题?

function ProductList() {

const [products, setProducts] = useState([]);

const [currentPage, setCurrentPage] = useState(1); // 当前页

const [pageSize, setPageSize] = useState(10); // 每页数量

const [totalCount, setTotalCount] = useState(0); // 总数量

const [isLoading, setIsLoading] = useState(false); // 页面loading状态

const [error, setError] = useState(null); // 页面error状态

useEffect(() => {

let isMounted = true; // 防止卸载后setState警告

const fetchData = async () => {

try {

setIsLoading(true);

const res = await fetch("/api/products");

if (!res.ok) throw new Error("请求失败");

const data = await res.json();

if (isMounted) setProducts(data);

} catch (err) {

if (isMounted) setError(err);

} finally {

if (isMounted) setIsLoading(false);

}

};

fetchData();

return () => {

isMounted = false;

};

}, []);

if (isLoading) return <div>加载中...</div>;

if (error) return <div>出错了:{error.message}</div>;

return (

<ul>

{products.map((p) => (

<li key={p.id}>{p.name}</li>

))}

</ul>

);

}

以下的书写方法是不是不会散落?易于阅读?

const [listData, setListData] = useState({

users: [],

totalCount: 0,

});

const [pagination, setPagination] = useState({

currentPage: 1,

pageSize: 10,

});

const [uiState, setUiState] = useState({

isLoading: false,

error: null,

});

function fetchUsers() {

setUiState({ isLoading: true, error: null });

api

.getUsers(pagination.currentPage)

.then((res) => {

setListData({

users: res.data,

totalCount: res.total,

});

setUiState({ isLoading: false, error: null });

})

.catch((err) => {

setUiState({ isLoading: false, error: err.message });

});

}

是否所有的数据都需要用 useState 包裹?

totalCount 这个东西真的是要放在 state 中吗?

const [listData, setListData] = useState([]);

function addItem(item) {

setListData([...listData, item]);

}

function removeItem(itemId) {

setItems(listData.filter((i) => i.id !== itemId));

}

// 这些都是计算出来的,不需要 state

const totalCount = listData.length;

// 如果是购物车价格的话

const totalPrice = listData.reduce((sum, item) => sum + item.price, 0);

vue 中的 compute 是一个带缓存的好东西。

react 中,可以考虑使用 useMemo, useCallback之类的来实现相同的功能。

优雅的设计 store,使用 getter 等方法

3、 如何封装成组件?

组件应该完成的本职工作:

- 渲染

loading,error - 根据

listData渲染列表 - 分页

pagination显示 - 卸载时清理

外部向组件传递的参数:

- 获取数据的

api pagination- 如果必要的话,自定义的

loading,error

拆分的 hook

function Page() {

const [otherQueryParams, setOtherQueryParams] = useState("xx");

const { data, loading, error, pagination } = usePagination(

({ pageNum, pageSize }) => {

return getList({

pageNum,

pageSize,

otherQueryParams,

});

},

[deps]

);

const { pageNum, pageSize, total, onChange } = pagination;

return (

<>

<List

loading={loading}

error={error}

run={run}

pageSize={pageSize}

pageNum={pageNum}

data={data}

/>

<Pagination

pageNum={pageNum}

pageSize={pageSize}

total={total}

onChange={onChange}

/>

</>

);

}

// 纯组件,只负责展示

function List({ data, loading, error, run, pageSize, pageNum }) {

if (loading) {

return <Loading />;

}

if (error) {

return <Error />;

}

return (

<ul>

{data.map((i) => (

<li>{i}</li>

))}

</ul>

);

}

关于 ahook 和 usePagination

感兴趣的可以自行封装一下,或者参考 ahook 源码。

3、 AbortController,优雅的取消一次请求并且方式内存泄漏

如果页面组件已经卸载,而网络请求此时才完成,那么尝试 setState 的时候,有可能会导致内存泄漏。

// 创建控制器

const controller = new AbortController();

const signal = controller.signal;

// 发起请求时关联signal

fetch("https://api.example.com/data", { signal })

.then((response) => response.json())

.then((data) => console.log(data))

.catch((error) => {

if (error.name === "AbortError") {

console.log("请求已取消");

}

});

// 需要取消时调用

controller.abort();

import { useState, useEffect } from "react";

import { Card, CardBody, CardTitle } from "reactstrap";

const SafeDataFetcher = () => {

const [data, setData] = useState(null);

useEffect(() => {

const controller = new AbortController();

const signal = controller.signal;

const fetchData = async () => {

try {

const response = await fetch("https://api.example.com/data", {

signal,

});

const result = await response.json();

setData(result);

} catch (error) {

if (error.name !== "AbortError") {

console.error("请求失败:", error);

}

}

};

fetchData();

// 组件卸载时取消请求

return () => {

controller.abort();

};

}, []);

return (

<Card>

<CardBody>

<CardTitle>安全数据加载</CardTitle>

{data ? JSON.stringify(data) : "加载中..."}

</CardBody>

</Card>

);

};

模块支持方案

webpack 支持 CommonJS(配置文件是 Node 环境下运行的),AMD,ES6 Module 规范。

核心概念

从 entry 进入项目,经过 loader、plugin 打包,之后输出 output

entry、output

entry可以是单个字符串,也可以是一个字符串数组(多入口),一般写成对象格式。 key表示名字,value表示入口文件。

详细可以参考官方文档。

module.exports = {

// entry: 'xxx',

// entry: ['a', 'b'],

entry: {

app: "./app.js",

app2: "./app2.js",

},

};

output就是输出的结果文件。官方文档。

const path = require("path");

module.exports = {

entry: {

app: "./app.js",

},

output: {

path: path.resolve(__dirname, "dist"),

filename: "[name].[hash:6].[id].[chunkhash].bundle.js", // name对应上面enrty的key

},

};

loader

是webpack的编译方法,webpack自身只能处理JavaScript,所以需要依赖loader来处理别的类型的资源文件。

webpack只能负责打包,相关的编译工作也需要依赖loader处理。 loader本质上只是一个方法,使用时基本需要额外安装。

使用时,在rules数组中使用,loader的执行顺序符合从右往左(从下到上、从数组的最后执行到第一个,compose)

module.exports = {

module: {

rules: [

{

test: /\.css$/, // 用正则匹配什么类型的文件

use: [

{ loader: "style-loader" }, // 用什么loader处理

{

loader: "css-loader",

options: {

// loader的配置项

modules: true,

},

},

{ loader: "sass-loader" },

],

},

],

},

};

常见的 loader

css-loader,style-loader等处理css的loaderurl-loader,image-loader等图片文字文件等资源处理的loaderless-loader,sass-loader,babel-loader等编译loadervue-loader等语法糖loader

plugin

plugin是webpack的额外扩展:

- 一些插件式的额外功能由

plugin定义,帮助webpack优化代码,提供功能。 plugin也有一些是webpack自带的,也有需要额外安装的。

const HtmlWebpackPlugin = require("html-webpack-plugin");

const webpack = require("webpack"); // 访问内置的插件

const path = require("path");

module.exports = {

entry: "./path/to/my/entry/file.js",

output: {

filename: "my-first-webpack.bundle.js",

path: path.resolve(__dirname, "dist"),

},

module: {

rules: [

{

test: /\.(js|jsx)$/,

use: "babel-loader",

},

],

},

plugins: [

new webpack.ProgressPlugin(),

new HtmlWebpackPlugin({ template: "./src/index.html" }),

],

};

常见的 plugin

commonsChunkPlugin,uglifyjsWebpackPlugin,PurifyCss等优化文件体积的插件

HtmlWebpackPlugin,HotModuleReplacementPlugin等

编译 ES6

需要安装的 loader

npm install babel-loader @babel/core --save-dev

Babel-preset

presets 是存储 JavaScript 不同标准的插件,通过正确使用 presets,来告诉 babel 按照哪个规范编译。 常见规范:

- es2015

- es2016

- es2017

- env(通常采用,包括上面的三个和浏览器规范)

- babel-preset-stage

npm install @babel/preset-env --save-dev

编译 ES6 的方法

babel-polyfill 在打包代码里注入一个全局对象里,对象里定义了 ES6 所有的方法的 ES5 实现。适用于项目开发。

可以在入口文件中直接import 'babel-polifill' 也可以在 entry 中新增 babel-polyfill

babel-plugin-transform-runtime 生成一个局部对象,只会生成使用过的方法的实现。一般适用于框架开发。严格控制大小。

npm install babel-polyfill --save-dev

npm install @babel/plugin-transform-runtime @babel/runtime --save

webpack 配置

module.exports = {

entry: {

app: "./app.js",

},

output: {

filename: "[name].[hash:8].js",

},

module: {

rules: [

{

test: /\.js$/,

use: {

loader: "babel-loader",

options: {

presets: [

[

"@babel/preset-env",

{

targets: {

browsers: [">1%"],

},

},

],

],

},

},

},

],

},

};

编译 Typescript

- 安装 Typescript 和 ts-loader

- 写入 webpack.config.js

- 配置 tsconfig.json

编译 css

css-loader,让css可以被js正确的引入style-loader,让css被引入后可以正确的以一个style标签插入页面- 必须先过

css-loader,再过style-loader

style-loader 的一些配置项

insertAt:style标签插入在哪一块区域insertInto: 插入指定的domsingleton: 是否合并为一个style标签transform: 在浏览器环境下,插入style到页面前,用js对css进行操作

css-loader 的一些核心配置

minimize: 是否压缩(webpack4以上不支持这个,推荐使用uglifyjsWebpackPlugin)module: 是否进行css模块化alias:css中的全局别名(webpack4以上不支持这个)

less,sass

是 css 的预处理语言

less: less,less-loader sass: sass-loader, node-sass

{

rules: [

{

test: /\.less$/,

use: [{

loader: "style-loader",

options: {

// insertInto: "xxx",

singleton: true,

transform: "./transform.js"

}

},

{

loader: "css-loader",

options: {

modules: {

localIdentName: "[path][name]_[local]_[hash:4]"

}

}

},

{

loader: "less-loader"

}]

},

],

}

提取 css 代码

extract-text-webpack-plugin把 css 提取为单独的文件

{

rules: [

{

test: /\.less$/,

use: extractTextCss.extract({

fallback: {

loader: "style-loader",

options: {

// insertInto: "xxx",

singleton: true,

transform: "./transform.js"

}

},

use: [

{

loader: "css-loader",

options: {

modules: {

localIdentName: "[path][name]_[local]_[hash:4]"

}

}

},

{

loader: "less-loader"

}

]

})

},

],

// ...

plugins: [

new extractTextCss({filename: '[name].min.css'})

]

}

css 兼容性处理

post-css,再配合 browserlist

HTML 的处理和打包

html-webpack-plugin

filename指定打包生成的html的名字template指定一个html文件为模板minify压缩htmlinject是否把js,css文件插入到html,插入到哪里chunks多入口时,指定引入chunks

new htmlWebpackPlugin({

filename: "index.html",

template: "./index.html",

});

环境变量

env 参数可以根据不同的指定,产生不同的配置文件,用来适应生产、测试、开发环境的不同需求

图片处理

url-loader,file-loader,img-loader

{

test: /\.(png|jpg|jpeg|gif)$/,

use: {

loader: 'file-loader',

options: {

name:'[name].[hash].[ext]',

outputPath: '',

publicPath: ''

}

}

}

url-loader 可以多一些参数配置

{

test: /\.(png|jpg|jpeg|gif)$/,

use: {

loader: 'url-loader',

options: {

name:'[name].[hash].[ext]',

outputPath: '',

publicPath: '',

limit: 5000 //可以将小的资源文件进行base64转码

}

}

}

img-loader 可以进行图片压缩

{

test: /\.(png|jpg|jpeg|gif)$/,

use: [{

loader: 'url-loader',

options: {

name:'[name].[hash].[ext]',

outputPath: '',

publicPath: '',

limit: 5000 //可以将小的资源文件进行base64转码

}

}, {

loader: 'img-loader',

options: {

plugins: [

require('imagemin-pngquant')({

speed: 5 // 1-11,越大,压缩率越小

}),

require('imagemin-mozjpeg')({

quality: 80 // 1-100,质量,压缩率

}),

require('imagemin-gifsicle')({

optimizationLevel: 1, // 1-3

}),

]

}

}]

}

代码分割

多入口要配置多个 HTMLWebpackPlugin,filename 和 chunks 也要指定好

多页面应用时需要提取公共依赖,打包成一个文件。(主业务代码+公共依赖+第三方包+webpack 运行代码)

单页面应用主要是把需要异步加载改成异步加载,把业务代码和第三方代码拆分,保持纯净。(主业务代码+异步模块+第三方包+webpack 运行代码)

- webpack3, commonChunksPlugin

- webpack4, SplitChunksPlugin

{

optimization: {

splitChunks: {

// initial, all ,async

chunks: "initial",

minSize: 0,

// 自定义提取

cacheGroups: {

vendor: {

test: /([\\/]node_modules[\\/])/,

name: 'vendor',

chunks: 'all'

}

}

},

// webpack运行时代码

runtimeChunk: true,

}

}

异步模块加载,命名

import(/* webpackChunkName:"mA" */ "./moduleA.js");

require.ensure([], function () {

require("./moduleA.js");

});